时间序列分析自学笔记 Time Series Notes

- 【Author】:Jack Zhang, SYSU

- 【Textbook】:Applied Econometric Time Series(4e), Walter Enders

- 【Original Slides】:https: //www.time-series.net/powerpoint_slides

Chapter 1: Difference Equations 差分方程

[!IMPORTANT] 本章学习目标

- 阐述随机差分方程如何用来预测,说明该方程如何产生于熟悉的经济模型。

- 阐述差分方程的解的含义。

- 阐述如何用迭代求解随机差分方程。

- 阐述如何求差分方程的齐次解。

- 阐述求齐次解的过程。

- 阐述如何求高阶差分方程的齐次解。

- 阐述如何求确定的差分方程的特解。

- 阐述如何用待定系数法求随机差分方程的特解。

- 阐述如何用滞后因子求随机差分方程的特解。

1.1 时间序列模型

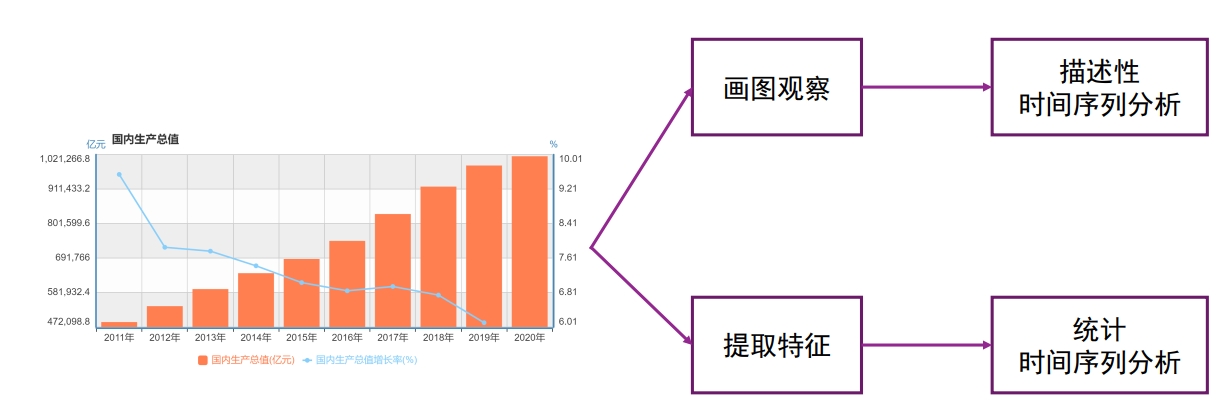

当我们拿到一个时间序列模型,我们可能不假思索地就能说出一些直观的信息。比如,GDP 逐年增长的趋势、增速放缓的趋势。这就是直观的描述性分析。

但是,很多规律并不那么容易发现——他们潜藏在大量的复杂的数据背后。我们研究模型的目的就是理解这些潜在的规律,并用以预测。这时,模型的作用就是 提取特征,用统计学的语言使得这些特征从模糊的感觉转变为确切的定理。

那么,有什么方法可以 “提取特征” 呢? 当前,时间序列分析主要有两大“流派”——统计时间序列分析 和 机器学习方法。统计时间序列分析基于统计学方法对时间序列的概率特性进行估计,一般基于(线性) 随机过程假设。我们之前学习的 AR 模型、MA 模型、ARMA 模型等都属于这一类。另一类是机器学习方法,顾名思义,是基于机器学习方法从历史或相关序列中学习时间序列预测的方法。比如基于近邻的方法、RNN/LSTM、Transformer、TCN、Meta-Learning 等。我们目前主要学习的是统计时间序列分析方法。

1.1.1 时间序列分析的用途

传统用途:预测

基于线性模型 \(y_{t+1} = a_0 + a_1 y_t + \varepsilon_{t+1}\),已知当期 \(y_t\),预测下一期期望 \(E_t[y_{t+1}] = a_0 + a_1 y_t\)。

那么,\(t+2\) 期?在第一期的基础上递推。

- \(y_{t+2}=a_0+a_1y_{t+1}+\varepsilon_{t+2}\)

- \(E_{y_{t+2}}=a_0+a_1E_{y_{t+1}}=a_0+a_1(a_0+a_1y_t)=a_0+a_1a_0+(a_1)^2y_t\)

“递推”的本质就是【迭代】,即本章的核心内容。

例如:通过滞后一期的价格预测下一期价格,GDP 预测。

现代用途:

- 动态关系捕捉:分析变量间的滞后影响(如货币政策对经济的滞后效应)。

- 假设检验:验证经济理论(如随机游走假设)。

- 发展“典型事实”:从数据中提炼规律(如商业周期的波动特征)。

1.1.2 典型的时间序列问题

【单方程模型】随机游走假设:

- 模型:\(y_{t+1} = y_t + \varepsilon_{t+1}\),即 \(\Delta y_{t+1} = \varepsilon_{t+1}\)。

- 检验:对更一般的方程 \(\Delta y_{t+1} = a_0 + a_1 y_t + \varepsilon_{t+1}\),需验证 \(a_0 = a_1 = 0\)。

- 第 2 章到第 4 章将再次讨论如何恰当地估计单方程模型。

【诱导方程和结构方程】

- 结构方程(structural equation)的内生因变量依赖于另一个内生变量(自变量)的当期实现值。

- 诱导方程(reduced-form equation,我们也常说是简约式,例如计量中的 IV 估计)则是将内生变量表示成该变量 滞后值、其他内生变量的 滞后值、外生变量 的当期和过去值以及 扰动项 的函数。

- 我们可以简单的用“是否自变量纯粹为滞后变量”来判别。

[!Example]

【例】 \[ \begin{cases} y_t = c_t + i_t \\ c_t = \alpha y_{t-1} + \varepsilon_{ct} \quad 0 < \alpha < 1 \\ i_t = \beta (c_t - c_{t-1}) + \varepsilon_{it} \quad \beta > 0 \end{cases}\notag \]

消费函数中的当期消费仅仅依赖于滞后收入 \(y_{t-1}\) 和扰动项 \(\varepsilon\) ,它已经表示成了诱导方程。

而投资函数还不是诱导方程,因为当期投资还依赖于当期消费。那么,它的投资函数的诱导方程是什么?

\[ \begin{align} i_t &= \beta (c_t - c_{t-1}) + \varepsilon_{it} \notag \\ &= \beta (\alpha y_{t-1} + \varepsilon_{ct} - c_{t-1}) + \varepsilon_{it} \notag \\ &= \alpha \beta y_{t-1} - \beta c_{t-1} + \beta \varepsilon_t + \varepsilon_{it} \notag \end{align} \notag \]

【练习】:请推导 \(y_t\) 的诱导方程。如果消去所有 \(c\) 呢?

我们可以进一步简化得到下面的形式:

\[ y_t = ay_{t-1} + by_{t-2} + x_t \notag \]

这是一个单变量诱导方程,\(y_t\) 完全被表示为其滞后值和干扰项的函数。单变量模型用于预测特别有效,我们只需根据它当期和过去的实现值,就可对序列进行预测。

在学完第 2 章到第 4 章阐述的单变量时间序列分析方法后,第 5 章讨论当所有变量都被当作联合内生变量时的多变量模型估计。该章也讨论从已估诱导模型还原到结构模型所需的约束条件。

- 【误差纠正】无偏远期汇率(UFR)假设:

- 模型:\(s_{t+1} = f_t + \varepsilon_{t+1}\),其中 \(s_{t+1}\) 为未来即期汇率,\(f_t\) 为当前远期汇率。

- 回归检验:\(s_{t+1} = a_0 + a_1 f_t + \varepsilon_{t+1}\),要求 \(a_0 = 0\)、\(a_1 = 1\),且残差 \(\varepsilon_{t+1}\) 均值为零。

- 调整机制:若 \(s_{t+1}

\neq f_t\),后续汇率和远期利率会通过下面的误差纠正模型联立调整:

- 如果即期汇率与远期汇率相等(\(s_{t+1} = f_t\)),则即期和远期汇率倾向于保持不变。

- 如果即期与远期汇率之差为正,即 \(s_{t+1} - f_t>0\),则预期:即期汇率会趋于下降,远期汇率会趋于上升。

\[ \begin{cases} s_{t+2} = s_{t+1} - a(s_{t+1} - f_t) + \varepsilon_{s, t+2} \\ f_{t+1} = f_t + b(s_{t+1} - f_t) + \varepsilon_{f, t+1} \notag \end{cases} \]

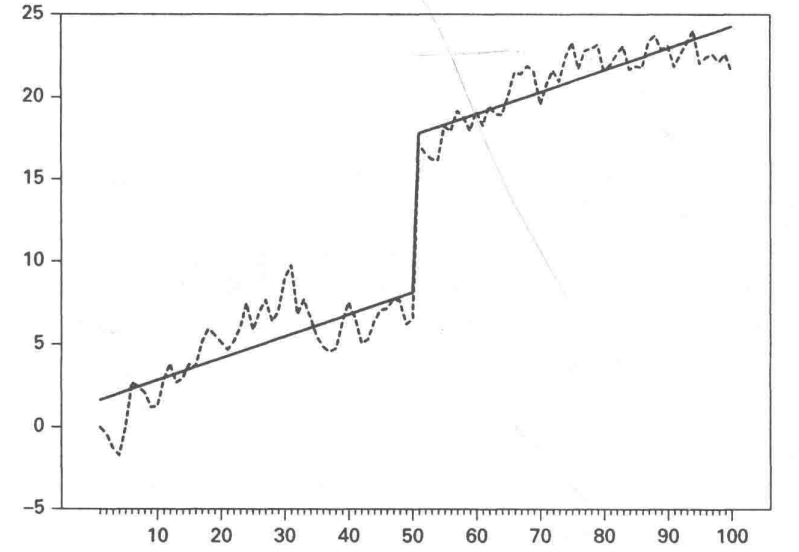

- 【非线性动态模型】趋势-周期关系:

- 分解公式:\(y_t = Trend + Cycle + Noise\)。

- 趋势:长期稳定增长或下降(如 GDP 的长期趋势)。

- 周期:围绕趋势的短期波动(如商业周期)。

- 噪声:随机不可预测部分(如突发政策冲击)。

- 应用:摩擦性失业(Noise)、结构性失业(Trend,如房地产业)、周期性失业(Cycle,如经济危机)

第 7 章将专门讨论一些具有更为复杂的 动态结构模型 的估计。

1.2 平稳性

平稳性是时间序列分析的基础。

平稳性的存在使得不同时间点的随机变量具有类似的统计性质,这是统计推断和预测的基础。类比随机实验,任何一次实验的统计性质是一致的,因此,可以进行统计推断。

平稳序列围绕 x 轴上下波动,非平稳序列则无序波动。平稳的本质是让系统稳定,让变量收敛。

平稳性有 严平稳(strictly stationary)和 弱平稳(weakly stationary)之分。

严平稳是非常强的假设,它认为只有当序列所有的统计性质都不会随着时间的推移而发生变化时,该序列才被认为平稳。该假设使时间序列与无数次随机实验一致,这难以用经验方法验证。

弱平稳又被称为宽平稳。弱平稳不对随机变量的分布作要求,这就类似于每一次随机实验,可以是不同的实验,但任意两次实验之间存在一定关系,即均值和协方差。弱平稳下数据的时间序列图是围绕一个常数水平以相同的幅度上下波动。弱平稳性使我们可以对未来观测进行推断,即预测。

严平稳太过严格,我们通常考虑弱平稳序列。

[!NOTE] 弱平稳的定义:

对于任意整数 \(l\),如果 \(y_t\) 的均值,以及 \(y_t\) 和 \(y_t-l\) 的协方差不随时间而改变,那么时间序列 \(y_t\) 是弱平稳的。

换言之,当:\(\mathbb{E}(y_t)\) 是常数、\(\mathbb{Cov}(y_t, y_{t-l})\) 只依赖于 \(l\) 时,时间序列 \(y_t\) 是弱平稳的。

其中,\(\gamma_l = \mathbb{Cov}(y_t, y_{t-l})\) 称为 \(y_t\) 的间隔为 \(l\) 的 自协方差,它满足: (1)当 \(l=0\) 时, \(\gamma_0 = \mathbb{Cov}(y_t, y_t) = \mathbb{Var}(y_t)\); (2)\(\gamma_l = \gamma_{-l}\) 这表明自协方差对于“预测未来“和”追溯过去”都是适用的。

对应的,我们也可以定义 自相关系数。\(\rho = \dfrac{\gamma_l}{\gamma_0}\),也即是 \(\rho = \dfrac{\mathbb{Cov}(y_t, y_{t-l})}{\mathbb{Var}(y_t)}\)

或者,我们更通俗地认识:

[!Tip] 弱平稳(协方差平稳)需满足的条件:

- 均值恒定:\(E(y_t) = \mu\)(各时期数学期望恒定)

- 方差恒定:\(\text{Var}(y_t) = \sigma^2\)(各时期方差恒定)

- 协方差仅依赖时间间隔(而不随时间变化):\(\text{Cov}(y_i, y_j) = \gamma_{|i-j|}\)(任意两时期的协方差仅与时间间隔绝对值有关)

怎么好像多了一个条件?事实上,方差恒定可以被涵盖在协方差不随时间变化的条件中。

1.3 差分方程及其解

1.3.1 什么是差分?

- 我们首先认识一下“差分算子”,虽然名字很陌生,但事实上我们在学习微积分的时候就已经了解它了。让我们回忆亿下高数的导数内容:

[!Note] 导数的定义

导数描述了一个函数在某一点处的变化率。导数的定义基于极限的概念。

给定一个实数函数 \(f(x)\),如果存在极限 \[ f'(x) = \lim_{h \to 0} \frac{f(x+h) - f(x)}{h} \notag \] 那么,这个极限值称为函数 \(f(x)\) 在点 \(x\) 处的导数 。或者,我们常简写为: \[ f'(x) = \lim_{\Delta x \to 0} \frac{\Delta y}{\Delta x} \notag \]

\(\Delta\) 就是差分算子。一阶差分本质上就是做差。

微积分中允许自变量的变化趋近于零。但由于大多数经济数据都是离散型的,所以,允许时间跨度大于零会更有益。运用差分方程时,我们将单位标准化,使 \(h\) 代表时期(例如,\(h=1\))的单位变化。

一阶差分 \(\Delta y_t = y_t - y_{t-1}\)。

二阶差分 \(\Delta^2 y_t \equiv \Delta(\Delta y_t) = \Delta(y_t - y_{t-1}) = (y_t - y_{t-1}) - (y_{t-1} - y_{t-2}) = y_t - 2y_{t-1} + y_{t-2}\)

类似地,可以给出 n 阶差分的定义。此时,我们已 冒险 将差分方程理论推广得过远。在时间序列分析中,很少需要使用差分。在实际应用中,几乎不会使用 3 阶及更高阶的差分方程。

为什么是 “冒险”?——类比于天气预报,更长期限的预测更失真。在第 1.4.2.1 节中(1.4.2.1 迭代法),我们有更数理直观的解释。

1.3.2 什么是差分方程?

通常形式下,差分方程 将变量表示为该变量滞后值、时间和其他变量的函数。

Note

趋势性:\(T_t = 1 + 0.1t\)

季节性:\(S_t = 1.6\sin\left(\frac{t\pi}{6}\right)\)

无规则:\(I_t = 0.7I_{t-1} + \varepsilon_t\)

其中,趋势成分和季节成分都是时间 \(t\) 的函数,而无规则成分则是它的滞后值和随机变量 \(\varepsilon\) 的函数。

由于大部分情况下,我们讨论的是线性时间序列,可以只考察带常数系数的 \(n\) 阶线性差分方程的特例。这种特殊类型的差分方程的形式为:

\[ y_t = a_0 + \sum_{i = 1}^{n} a_i y_{t-i} + x_t \notag \]

公式的结构可以分解为以下几个部分:

常数项 \(a_0\)

过去输出值的加权和:\(\sum_{i=1}^{n} a_i y_{t-i}\),即从 \(t-1\) 到 \(t-n\) 的所有过去输出值的线性组合。\(a_i\) 是权重。

当前外部输入 \(x_t\)(驱动因素、激励 、推动过程)。它可能是时间、其他变量的当期值或滞后值,和(或)随机干扰项的任一函数。通过恰当地选择推动过程,我们就可以得到大量重要的宏观经济模型。

你可能会差评:这个差分方程看起来一点也不差分。的确,让我们给它变个形:

\[ \Delta y_{t} = y_{t}-y_{t-1}= a_0+(a_1-1) y_{t-1}+\sum_{i = 2}^{n}a_{i}y_{t-i}+x_{t}\notag \]

它变丑了,也变得更让人眼熟了。

1.4 差分方程的求解方法

1.4.1 差分方程的解

好了,我们现在认识了差分方程。这就够了吗?当然不。我们的目标是估计它,换言之,我们要:求解差分方程。

在求解之前,我们最好还是先明确我们的预期目标,也就是 差分方程的解(solution)。

差分方程的解是将 \(y_t\) 值表示为序列 \(x_t\) 的元素和 \(t\) 的函数。解式中可能包括一些初始条件(initial condtion,即 \(y_t\) 的一些给定值)。

Tip

解的主要特征在于:当时间 \(t\) 和外部输入的 \(x\) 取任何允许值时,它都满足差分方程。这使得我们可以对解进行验证。

换言之,只要满足差分方程,它就是差分方程的解。

【引例】:考察简单差分方程 \(\Delta y_t = 2\) 的解

由于 \(\Delta y_t = y_t - y_{t-1} = 2\),我们很容易证明 \(y_t\) 是公差为 2 的等差数列。\(y_t = 2t + c\) 是差分方程 \(\Delta y_t = 2\) 的解,这里 \(c\) 为任意常数。

根据定义,如果 \(2t + c\) 为一个解,则必定满足 \(t\) 的所有允许值。因此,对于 \(t-1\) 期,有 \(y_{t-1} = 2(t-1) + c\),现在将解代入方程得:\(2t + c \equiv 2(t-1) + c + 2\)。这是一个恒等式。这也说明差分方程的解不是唯一的,\(c\) 的任意一个取值都对应着一个解。

我们发现,差分方程的解有点像通项公式。事实上,一阶线性递推数列的通项公式是“常数+等比”;二阶线性递推数列的通项公式是“等比+等比”的形式。

Tip

解是一个函数而非数字。类似于数列的通项公式,我们最终求解差分方程的目标是一个涵盖每一个“特解”的函数,称为“通解”。我们将在后面的迭代法中介绍(尽管这些概念并不依赖于迭代求解方法)。

1.4.2 迭代法求解差分方程

尽管迭代法是一种最麻烦、最耗时的方法,但它很直观。

1.4.2.1 迭代法

一阶方程迭代:

方程:\(y_t = a_0 + a_1 y_{t-1} + \varepsilon_t\)。

迭代过程:

- 第一期 \(y_1 = a_0 + a_1 y_0 + \varepsilon_1\)。

- 第二期 \(y_2 = a_0 + a_1 y_1 + \varepsilon_2 = a_0(1 + a_1) + a_1^2 y_0 + a_1 \varepsilon_1 + \varepsilon_2\)。

- 第三期 \(y_3 =a_0 + a_1 y_2 + \varepsilon_3 = a_0(1 + a_1 + a_1^2) + a_1^3 y_0 + a_1^2 \varepsilon_1 + a_1 \varepsilon_2 + \varepsilon_3\)。

- 第 \(t\) 期 ?

\[ y_t = a_0 \sum_{i = 0}^{t-1} a_1^i + a_1^t y_0 + \sum_{i = 0}^{t-1} a_1^i \varepsilon_{t-i} \notag \]

Tip

更多次的迭代,就有更大的误差。这在数理上呼应了 1.3.1 什么是差分? 关于更长时间序列预测的“冒险”。

极限情况:当 \(t \rightarrow ∞\) 时

当 \(|a_1| < 1\) 时:【第一项是几何级数,第二项趋于 0】

\[ y_t = \frac{a_0}{1 - a_1} + \sum_{i = 0}^∞ a_1^i \varepsilon_{t-i}\notag \]

思考:相对于其他情况,我们更关心 \(|a_1| < 1\) 的情况。为什么?

- 数理上,这时收敛。站在 \(t\) 期的节点上,上一期的 \(y_{t-1}\) 是已知的参数。当 \(|a_1| \geq 1\),无穷级数发散。

- 仅仅是因为数理上收敛可以求出吗?经济意义是什么?(Hint:类似于 WLS,你认为 2015 年 GDP 对今年 GDP 影响大还是 2024 年 GDP 对今年 GDP 影响大?所以我们应该怎么赋予权重?)

验证:这是 \(y_t = a_0 + a_1 y_{t-1} + \varepsilon_t\) 的解吗?代入公式验证是成立的。

如果 反向迭代,这个式子还成立吗?

\[ y_t = a_0 + a_1 y_{t-1} + \varepsilon_t \notag \]

将 \(y_{t-1}\) 代入上述表达式中:

\[ \begin{align} y_t &= a_0 + a_1 [a_0 + a_1 y_{t-2} + \varepsilon_{t-1}] + \varepsilon_t \notag\\ & = a_0 (1 + a_1) + a_1 \varepsilon_{t-1} + \varepsilon_t + a_1^2 [a_0 + a_1 y_{t-3} + \varepsilon_{t-2}] \notag \end{align}\notag \]

当 \(|a_1| < 1\) 时,\(t \rightarrow ∞\) 的极限情况:

\[ y_t = \frac{a_0}{1 - a_1} + \sum_{i = 0}^\infty a_1^i \varepsilon_{t-i}\notag \]

\[ y_t = \frac{a_0}{1 - a_1} + \sum_{i = 0}^\infty a_1^i \varepsilon_{t-i}\notag \]

- 通解:在第 1.4.1 节(1.4.1 差分方程的解)最后,我们提到:差分方程的解有点像通项公式。那么,应该能够写出一个 通解,以涵盖前面的各个解(称为 特解)。课本对通解的提出比较突兀,这是因为涉及了齐次解的内容,我们在第 1.4.2.2 节讨论这一点。

1.4.2.2 齐次解和通解

- 齐次解:

- 前面我们提到的是 \(y_t = a_0 + a_1 y_{t-1} + \varepsilon_t\),仅考虑其中的齐次部分,就是齐次方程。

- 一阶齐次方程:\(y_t = a_1 y_{t-1}\),这可以被视作等比数列,通项公式还记得吗?

- 该齐次方程的解称为 齐次解(homogeneous solution),为 \(y_t =A×(a_1)^t= A a_1^t\)(A 任取)。

- 收敛条件:\(|a_1| < 1\)。这与 1.2 平稳性 是呼应的。

[!Note] 一阶齐次方程的齐次解与平稳性

- 当 \(|a_1| < 1\) 时:

- 当 \(t\) 趋于无穷大时,\(a_1^t\) 收敛于零。

- 如果 \(0 < a_1 < 1\),则称为直接收敛。

- 如果 \(-1 < a_1 < 0\),则称为震荡收敛。

- 当 \(|a_1| > 1\) 时:

- 齐次解不稳定。

- 如果 \(a_1 > 1\),齐次解随 \(t\) 的增大趋于无穷大。

- 如果 \(a_1 < -1\),齐次解是震荡发散性的。

- 当 \(a_1 = 1\) 时:任意一个常数 \(A\) 都满足齐次方程 \(y_t = y_{t-1}\)。

- 当 \(a_1 = -1\) 时,方程的解正负交替变化:\(t\) 取偶数,\(a_1^t = 1\);\(t\) 取奇数,\(a_1^t = -1\)。

- 通解: 正如我们在第 1.4.1 节(1.4.1 差分方程的解)最后部分所指出的,差分方程的解更像一种通项公式。那么,应该能够写出一个 通解,以涵盖 \(y_t = a_0 + a_1 y_{t-1} + \varepsilon_t\) 的所有 特解。在第 1.4.2.1 节(1.4.2.1 迭代法)中,我们考虑到了一个比较特殊的特解:当 \(t \rightarrow ∞\) 时的特解:

\[ y_t = \frac{a_0}{1 - a_1} + \sum_{i = 0}^∞ a_1^i \varepsilon_{t-i}\notag \]

现在,我们构造 通解:其两个组成部分正是齐次解、特解。如上所述,齐次解为 \(y_t = A a_1^t\),A 可以任意取值。

\[ y_t = A a_1^t + \frac{a_0}{1 - a_1} + \sum_{i = 0}^{\infty} a_1^i \varepsilon_{t-i} \notag \]

在通解的基础上,如果我们再施加初始条件 \(y_0\),就可以消去任意常数 A 了。

1.4.3 解差分方程的通用步骤

我们已经分析了一阶的情况,现在考虑更高阶的。迭代法求解方程不宜用于高阶方程,在复杂的代数式面前,任何试图求解的努力都是徒劳的。那么,有什么好办法呢?

在经济分析中,出现更高阶的差分方程并不奇怪。根据萨缪尔森模型(1939)得到的 GDP 的诱导方程(见 1.1.2 典型的时间序列问题),就是 二阶差分方程 的例子。此外,在时间序列计量经济学中对二阶和更高阶差分方程的估计也相当典型。

[!TIP] 【通用步骤】 一阶例子中的结论直接适用于 n 阶差分方程。一般情况下,寻找特解更为困难,并且还有 n 个不同的齐次解。但是,解答时总是遵照以下四个步骤。

第 1 步:建立齐次方程,求出 n 个齐次解;

第 2 步:求出一个特解;

第 3 步:求特解和所有齐次解的一个线性组合,求和得出通解;

第 4 步:将初始条件代入通解中,消去任意常数。

要考察齐次差分方程的解法,首先,我们考察二阶差分。按照上面的步骤,我们做个例题:

[!Note] 【例 1】 求解 \(y_t = 0.9y_{t-1} - 0.2y_{t-2} + 3\),初始条件 \(y_{0}=13\),\(y_{1}=11.4\)

第 1 步:建立齐次方程

\[ y_t - 0.9y_{t-1} + 0.2y_{t-2} = 0 \notag \]

找到齐次解:稍后我们将说明如何找到完整的齐次解。现在,我们直接给出两个齐次解为:

\(y^h_{1t} = (0.5)^t \quad \text{和} \quad y^h_{2t} = (0.4)^t\)

要证明第一个解,应注意到 \(y^h_{1,t-1} = (0.5)^{t-1}\) 和 \(y^h_{1,t-2} = (0.5)^{t-2}\)。因此,如果满足:\((0.5)^t - 0.9(0.5)^{t-1} + 0.2(0.5)^{t-2} = 0\), 那么 \(y^h_{1t}\) 就是一个解。等式两边同除以 \((0.5)^{t-2}\),问题就变为是否满足下式:\((0.5)^2 - 0.9(0.5) + 0.2 = 0\)。显而易见,确实等于零,同理也可验证另一个。

第 2 步:求出一个特解。

显然,很容易证明特解 \(y_{t}^{p}=10\) 也是一个解,因为 \(10=0.9\cdot(10)-0.2\cdot(10)+3\)。

第 3 步:合并特解和两个齐次解的线性组合

\[ y_{t}= a_1(0.5)^{t}+A_{2}(0.4)^{t}+10 \notag \]

这里,\(a_1\) 和 \(A_{2}\) 为任意常数。

第 4 步:序列初始条件

在 0 期和 1 期,解必须满足

\[ \begin{cases} 13 = a_1+A_{2}+10 \\ 11.3 = a_1\cdot(0.5)+A_{2}\cdot(0.4)+10 \end{cases}\notag \]

联立求解,得 \(a_1=1,A_{2}=2\)。因此,\(y_t\) 的解为

\[ y_{t}=(0.5)^{t}+2(0.4)^{t}+10 \notag \]

1.4.4 高阶齐次解:特征根

第一步很麻烦,有没有什么办法?事实上,从验证齐次解的方式中,我们可以窥见特征根分析的端倪。下面,我们更系统地介绍如何得到齐次解。

设数列 \(\{x_n\}\) 的前两项 \(x_1\) 和 \(x_2\) 已知,且满足递推关系 \(x_{n+1} = px_n + qx_{n-1}\)。则称方程 \(x^2 - px - q = 0\) 为该数列的 特征方程。特征方程的根为该数列的 特征根。

Tip

- 方程:\(y_t - a_1 y_{t-1} - a_2 y_{t-2} = 0\)。

- 特征方程:\(\alpha^2 - a_1 \alpha - a_2 = 0\)。

- 根的情况:

- 实根且不同:\(y_t = A_1 \alpha_1^t + A_2 \alpha_2^t\)。

- 实根且相同:\(y_t = (A_1 + A_2 t) \alpha^t\)。

- 虚根:用欧拉公式表示为 \(y_t = r^t (C_1 \cos \theta t + C_2 \sin \theta t)\),其中 \(r = \sqrt{a_2}\),\(\theta = \arctan\left(\frac{\sqrt{4a_2 - a_1^2}}{a_1}\right)\)。

- 稳定性条件:所有特征根绝对值小于 1。稳定性条件要求 r < 1,因此,当把根绘制在复数平面上时,必须让它们位于一个半径为 1 的圆内。在时间序列文献中,稳定性条件的简单表述是:所有的特征根都位于单位圆之内。

我们再看个例子:

[!note] 【例 2】:求齐次解

- 方程:\(y_t = 0.2 y_{t-1} + 0.35 y_{t-2}\)。

- 特征方程:\(\alpha^2 - 0.2 \alpha - 0.35 = 0\),解得特征根 \(\alpha_1 = 0.7\),\(\alpha_2 = -0.5\)。

- 齐次解:\(y_t = A_1 (0.7)^t + A_2 (-0.5)^t\)。

很好!我们会算第一步了。返回刚才的例 1,我们可以重新算一下。

1.4.5 特解的处理

除了第一步对于高阶齐次解计算有着精妙的技巧,在例 1 中,我们非常不负责任的“显然易得”了特解。也很显然,我们的运气可能不总是能让我们“显然”发现特解。基于此,我们这一小节讨论特解的情况。需要强调的是,由于特解本就是“妙手偶得”的,我们在(1.4.4 高阶齐次解:特征根)中讨论的所有找特解方法都只是方便找特解的技巧。

1.4.5.1 推动过程为零的特解

寻找差分方程的特解需要智慧和毅力,方法的选取主要取决于序列 \(\{x\}\) 的形式。遵循由浅入深的原则,我们先讨论一种特殊情况的特解,即 当 \(x_t=0\) 时 的特解。

当序列 \(\{x_{t}\}\) 的所有元素均为零时,差分方程变为

\[ y_{i} = a_0 + a_1y_{i-1} + a_2y_{i-2} + \cdots + a_ny_{i-n}\notag \]

这和前面的例 2 非常相似,事实上,例 2 是给定参数的二阶特例。在第 1.4.4 节(1.4.4 高阶齐次解:特征根)中,我们只算出了例 2 的齐次解,还没有得到方程的通解。遵循第 1.4.3 节(1.4.3 解差分方程的通用步骤)的通用步骤,我们对方程 \(y_t = 0.2 y_{t-1} + 0.35 y_{t-2}\) 的求解还需要找到特解。通过下面对 \(n\) 阶情况的讨论,我们应该能够为例 2 的求解画上圆满的句号。

由于我们正在找的是特解,所以我们不用顾及任何“大而全”的普适性,只需要找最特殊的就足够了。直觉告诉我们,\(y\) 取相同值(即 \(y_i=y_{i-1}=\cdots=c\))应该是目标差分方程最特殊的解了。虽然我们在这里也不可避免的“显然易得”了,但相较于例 1 的“显然”,这里的直觉容易得多。将常解 \(y_i=c\) 代入得到 \(c=a_0+a_1c+a_2c+\cdots+a_nc\),因而

\[ c =\dfrac{a_0}{1-a_1-a_2-\cdots-a_n}\notag \]

由于分式的分母不能为 0,我们分类讨论:

只要 \((1-a_1-a_2-\cdots-a_n)\) 不等于零,\(c\) 值就是差分方程的解。因此,差分方程的特解就为 \(y^p_i=\dfrac{a_0}{1-a_1-a_2-\cdots-a_n}\)。

如果 \(1-a_1-a_2-\cdots-a_n=0\),\(c\) 值是待定的,必须寻找解的其他形式。课本的讨论为我们提供了下一步的方向:我们应该考虑尝试 \(y^p_i=ct\) 作为解,如果还不成立,就继续尝试 \(y^p_i=c \cdot t^2\)、\(y^p_i=c \cdot t^3\)…… 总有一个会是特解的。

接下来,我们兑现前面的承诺,对例 2 的特解进行讨论。

[!Note] 【例 2】 的特解

对于方程:\(y_t = 0.2 y_{t-1} + 0.35 y_{t-2}\),我们取常解 \(y_i=c\) 的特殊情况。代入得:

\[ c =\dfrac{a_0}{1-a_1-a_2}\notag \]

其中,\(a_0=0\),\(a_1=0.2\),\(a_2=0.35\)。我们得到差分方程的特解 \(c\),发现就等于 0。更正式一点的写法是:

\[ y^p_i =\dfrac{a_0}{1-a_1-a_2}= 0 \notag \]

有了特解 \(y^p_i=0\) 和齐次解 \(y_t = A_1 (0.7)^t + A_2 (-0.5)^t\),我们就可以得到该差分方程的通解了。

1.4.5.2 待定系数法

那么,如果特解比较随机,怎么处理?

当序列 \(\{y_t\}\) 含有随机成分时,有两种求特解的方法。我们先讨论待定系数法。

待定系数法的关键在于,线性方程具有线性解。因此,一个线性差分方程的特解必定是线性的。此外,求得的解仅依赖于时间、常数和推动过程的元素。因此,即使解的系数未知,仍有可能求得解的准确形式。这种方法涉及一个假设的解,可称这个假设的解为 挑战解(challenge solution),它是实际方程中应当出现的所有项的线性函数。这样,问题就转化成了寻找所有满足差分方程解的待定系数的值。

1.4.5.2.1 含有确定性成分的情况

我们首先看两个含有确定性成分的情况:

- 情况 1:含指数的例子。

在这种情况下,我们令 \(x_t\) 取指数形式 \(b \cdot (d)^{rt}\),其中,b、d、r 都为常数。由于 r 通常被解释为增长率,我们在有关增长的研究中更可能碰到它。我们运用一阶差分方程阐述求解过程:

\[ y_{i} = a_0 + a_1y_{i-1} +b \cdot (d)^{rt} \notag \]

特别地,当 \(b=0\) 的时候,差分方程退化为 \(x_t=0\) 的差分方程。事实上,我们可以把 \((d)^{rt}\) 看作 \({(d^{r})^t}\),即把 \(d^{r}\) 看作整体。

我们可以 假设特解的形式 为:(即挑战解为)

\[ y_{t}^{p}= c_0+c_1({d^{r})}^t \notag \]

其中,\(c_0\) 和 \(c_1\) 都是常数。如果该方程确实是一个解,可以将其代入递推公式得到一个恒等式。通过恰当的代换,得到

\[ c_0+c_1{d^r}^t = a_0+a_1 [c_0+c_1 {d^r}^{(t-1)}]+b{d^r}^t \notag \]

整理这个公式,如果这个公式成立,有 \(c_0\) 和 \(c_1\) 满足

\[ c_0 =\frac{a_0}{1-a_1}, c_1 =\frac{bd^r}{d^r-a_1} \notag \]

因此,特解就为

\[ y^p_t =\frac{a_0}{1-a_1}+\frac{bd^r}{d^r-a_1} \cdot {d^r}^t \notag \]

这个解的特点就是:\(y^p_t\) 等于常数 \(\dfrac{a_0}{1-a_1}\) 加上一个增速为 \(r\) 的表达式。

注意,对于 \(|d^r|<1\),特解会收敛为 \(\dfrac{a_0}{1-a_1}\)。

同样地,在 \(a_1=1\) 或 \(a_1=d^r\) 的时候,必须寻找解的其他形式。这时的技巧是:当 \(a_1 =1\) 时,尝试使用 \(c_0=ct\) 作为解;而当 \(a_1=d^r\) 时,尝试使用 \(c_1=tb\) 作为解。其中所用的方法完全适用于高阶方程。

- 情况 2:确定性时间趋势。 这时,序列 \(\{x_t\}\) 可表示为关系式 \(x_t= bt^d\),其中 b 为常数,d 为正整数。

\[ y_t = a_0 + \sum_{i = 1}^{t} a_i y_{t-i} + d \cdot t^d \notag \]

由于 \(y_t\) 依赖于 \(t^d\),则 \(y_{t-1}\) 依赖于 \((t-1)^d\),\(y_{t-2}\) 依赖于 \((t-2)^d\),等等。这样,特解的形式为:

\[ y_t^p = c_0 + c_1 t + c_2 t^2 + \cdots + c_d t^d \notag \]

为找到 \(c_i\) 的取值,可将特解代入,从 \(c_i\) 的恒等式中得到每个 \(c_i\) 的取值。

【发现】:这个特解的假设和情况 2 正好形成对照:

1 | |

尽管 \(d\) 可以取多个值,但在经济应用中,模型中通常含有一个线性时间趋势 (\(d=1\))。 举个例子,请考察 2 阶差分方程 \(y_t = a_0 + a_1 y_{t-1} + a_2 y_{t-2} + bt\)。假设解为:

\[ y_t^p = c_0 + c_1 t \notag \]

其中,\(c_0\) 和 \(c_1\) 都是待定系数,试着将这个“挑战解”代入该 2 阶差分方程,得到

\[ c_0 + c_1 t = a_0 + a_1 [c_0 + c_1 (t - 1)] + a_2 [c_0 + c_1 (t - 2)] + bt \notag \]

现在选择 \(c_0\) 和 \(c_1\) 的值,使得对 \(t\) 的所有可能取值都为恒等式。如果合并所有常数项和包括 \(t\) 在内的所有项,则所要求的 \(c_0\) 和 \(c_1\) 的取值就为

\[ \begin{cases} c_1 = \dfrac{b}{1 - a_1 - a_2} \\ \\ c_0 = \dfrac{a_0 - (2a_2 + a_1)c_1}{1 - a_1 - a_2} =\dfrac{a_0}{1 - a_1 - a_2} - \dfrac{b \cdot (2a_2 + a_1) }{(1 - a_1 - a_2)^2} \end{cases}\notag \]

1.4.5.2.2 一般化

我们已经考虑了含有确定性成分的情况,现在我们外推到一般化的情况。也就是说,我们考虑包含 \(\varepsilon_t\) 的 \(\{x_t\}\)。这时,我们应该如何使用待定系数法?

- 一阶方程:\(y_t = a_0 + a_1 y_{t-1} + \varepsilon_t\)。

序列 \(\{y_t\}\) 的特点是特征解仅依赖于常数项、时间 \(t\) 和序列 \(\{\varepsilon_t\}\)。因此,我们设定的挑战解应该包括常数项、时间趋势项和关于 \(\varepsilon\) 的项。

考虑到 \(\varepsilon\) 是白噪声(零均值、无自相关),其特解需体现历史扰动的累积效应,即:过去每一期误差项 \(\varepsilon\) 各自对当前值 \(y_t\) 的影响求和。由于各期对现在的影响不尽相同(越接近现在的权重应该更高,这在第 1.3.2 节中曾阐释过),因此对于每个误差项都应该配有对应的权重参数(记为 \(\alpha\),\(0<\alpha<1\))。由此,特解中应该包含 \(\sum_{i=0}^{\infty} \alpha_i \varepsilon_{t-i}\)。

综上,我们设定的挑战解为:

\[ y_t = b_0 + b_1 t + \sum_{i = 0}^{\infty} \alpha_i \varepsilon_{t-i} \notag \]

代入求解得,\(b_1=0\),\(b_0 = \frac{a_0}{1 - a_1}\)。

- 二阶方程:\(y_t = a_0 +

a_1 y_{t-1} + a_2 y_{t-2} + \varepsilon_t\)

- 挑战解:\(y_t = b_0 + b_1 t + b_2 t^2 + \sum_{i=0}^\infty \alpha_i \varepsilon_{t-i}\)。

- 代入求解:通过比较系数确定 \(b_0, b_1, b_2\) 及 \(\alpha_i\)。

首先,考虑当 \(a_1 + a_2 \neq 1\) 时的情况,由于 \((1 - a_1 - a_2)\) 不为零,那么,\(b_2\) 的取值必须等于 0。在 \(b_2 = 0\) 的情况下,又因为 \(t\) 的系数必须等于零,所以,\(b_1\) 也应为 0。在给定 \(b_1 = b_2 = 0\) 时,必得 \(b_0 = \dfrac{a_0}{1 - a_1 - a_2}\)。

相反,如果 \(a_1 + a_2 = 1\),则 \(b_t\) 的解的取值取决于 \(a_0, a_1\) 和 \(a_2\) 的特定取值。

关键在于齐次方程的稳定性条件就是特解的收敛条件。如果齐次方程的任意特征根都等于 1,那么,多项式时间趋势就将出现在特解中。多项式的阶数就是单位特征根的个数,这一结论也可推广到高阶方程。

1.4.5.3 滞后算子

如果不需要知道特解中的系数的实际值,则运用滞后算子(lag operator)的方法通常比待定系数法更为方便。

- 定义:滞后算子 \(L\) 被定义为线性算子,因而对 \(y_t\) 取任意值,均有:

\[ L^i y_t = y_{t-i} \notag \]

滞后算子 \(L\) 仅意味着将序列 \(y_t\) 向后移动一期,即 \(L{y_t} = y_{t-1}\)。请问,\(L^2_{y_t}=?\)

性质:

- 常数的滞后值为常数: \(L_c = c\)。

- 分配律:\(L(y_1 + y_2) = Ly_1 + Ly_2 = y_{t-1,1} + y_{t-1,2}\)。

- 结合律: \(L^iLy_j = L^{i+j}y = y_{t-i-j}\),注意 \(L^iy_t = y_{t-i}\)。

- 取负次方: 实际上为超前算子: \(L^{-1}y_t = y_{t+1}\)。为了便于解释,可定义 \(j = -i\),并设 \(L^jy_t = y_{t+j}\)。

- 无限求和:

- 对于 \(|\alpha| < 1\),有 \((1 + a L + a^2 L^2 + \cdots)L^n y_t = \dfrac{y_t}{1 - a L}\)。

- 对于 \(|\alpha| > 1\),有 \([1 + (aL)^{-1} + (aL)^{-2} + (aL)^{-3} + \cdots]y_t = \dfrac{-aL{y_t}}{1 - aL}\)。

滞后算子的应用:

- 滞后算子为书写差分方程提供了一种简洁的记号。运用滞后算子,可以将 p 阶方程 \(y_t = a_0 + a_1 y_{t-1} + \cdots + a_p y_{t-p} + \varepsilon_t\) 写为:

\[ (1 - a_1 L - a_2 L^2 - \cdots - a_p L^p) y_t = A(L) y_t = a_0 + \varepsilon_t \notag \]

其中,\(A(L)\) 为多项式 \((1 - a_1 L - a_2 L^2 - \cdots - a_p L^p)\)。它的成立是基于此前的 \(y\) 对于现在而言都是参数。

- 由于 \(A(L)\) 可被视为滞后算子的多项式,因此记号 \(A(1)\) 可用于表示所有系数之和:

\[ A(1) = 1 - a_1 - a_2 - \cdots - a_p \notag \]

- 用滞后算子解线性差分方程: 再次考虑一阶方程 \(y_{t}=a_0+a_1y_{t-1}+\varepsilon_{t}\),式中,\(\mid a_1 \mid <1\)。根据 L 的定义,构造

\[ y_t = a_0+a_1Ly_t+\varepsilon_t \notag \]

解 \(y_t\),我们得到:

\[ y_{t}=\frac{a_0+\varepsilon _{t}}{1-a_1L} \notag \]

根据性质(1),可知 \(La_0=a_0\),因而 \(\dfrac{a_0}{1-a_1L}=a_0+a_1a_0+a_1^{2}a_0+\cdots =\dfrac{a_0}{1-a_1}\)。

根据性质(5),可知 \(\dfrac{\varepsilon_{t}}{1-a_1L}=\varepsilon_{t}+a_1\varepsilon_{t-1}+a_1^{2}\varepsilon_{t-2}+\cdots\),合并解的两个部分,便得到迭代法得到的特解。

- 【一般化】滞后算子可以把方程表示为:

\[ y_t = a_0 + a_1 y_{t-1} + \cdots + a_p y_{t-p} + \varepsilon_t + \beta_1 \varepsilon_{t-1} + \cdots + \beta_q \varepsilon_{t-q} \Rightarrow A(L) y_t = a_0 + B(L) \varepsilon_t \notag \]

其中,\(A(L)\) 和 \(B(L)\) 分别为 p 阶和 q 阶的多项式。该模型的特解为:

\[ y_t = \frac{a_0}{A(L)} + \frac{B(L)\varepsilon_t}{A(L)}\notag \]

如果想了解序列的实际系数,最好采用待定系数法,滞后算子的魅力在于能够简洁地标记特解。

1.5 自回归(AR)模型

不知道你是否有注意到,在 1.4 节中,我们对差分方程的讨论主要围绕着的是 1.3.2 节提出的“一种特殊类型的差分方程”。现在,我们正式认识下这个“威名赫赫”的重要模型——自回归模型(Auto-regression Model),简称 AR(\(p\))。值得注意的是,这一节的内容大多数都已经在前面讲过,如果说前面的讲法更偏数学,这一节的讲法则是更统计学的。

1.5.1 自回归模型

[!Note] 定义(自回归模型) 如果时间序列 \(\{y_t\}\) 能用如下形式表示:

\[ \begin{split} y_t &= a_0 + a_1 y_{t-1} + a_2 y_{t-2} + \cdots + a_p y_{t-p} + \varepsilon_t \\ &= a_0 + \sum_{i = 1}^{p} a_i y_{t-i} + \varepsilon_t \notag \end{split} \]

则称 \(\{y_t\}\) 服从 \(p\) 阶自回归模型,记为 AR(\(p\)),其中,p 为模型的阶数, \(\varepsilon_t\) 是均值为 0、标准差为 \(\sigma_\varepsilon\) 的白噪声序列。

AR(\(p\)) 模型表示:给定过去的数据时,过去的 \(p\) 个值 \(y_{t-i}(i=1,2,\ldots,p)\) 联合决定 \(y_t\) 的条件期望。

1.5.2 AR(1)模型

- 当阶数 \(p = 1\) 时,AR(\(p\))模型简化为 AR(1)模型,即

\[ y_t = a_0 + a_1 y_{t-1} + \varepsilon_t, \quad \varepsilon_t \sim i.i.d. N(0, \sigma_\varepsilon^2) \notag \]

AR(1)模型刻画了一个随机过程或时间序列:\(\{r_t, t \in Z\}\);

根据 AR(1)模型定义有:

- 条件期望:\(E(y_t | y_{t-1}) = a_0 + a_1 y_{t-1}\)

- 条件方差:\(Var(y_t | y_{t-1}) = \sigma_\varepsilon^2\)

1.5.2.1 AR(1)的线性特征

正如我们在 1.4.2.1 迭代法 中所做的,将 AR(1)模型的递推可以得到

\[ y_t = a_0 \sum_{i = 0}^{t-1} a_1^i + a_1^t y_0 + \sum_{i = 0}^{t-1} a_1^i \varepsilon_{t-i} \notag \]

- 当 \(|a_1| < 1 \quad t \rightarrow ∞\),第一项是几何级数,第二项趋于 0,有:

\[ y_t = \frac{a_0}{1 - a_1} + \sum_{i = 0}^∞ a_1^i \varepsilon_{t-i}\notag \]

- 这是一个线性时间序列,被称为 MA(\(∞\)) 形式。自然地,我们会问:什么是 MA?MA 是移动平均模型的简写,我们会在 2.1.2 移动平均模型(MA) 内容中更详细的介绍它。关于 AR 和 MA 的互推条件,我们也将在 2.3.5.2 可逆性 中进一步论述。

1.5.2.2 AR(1)的平稳性

AR(1)模型的平稳性指时间序列 \(\{y_t\}\) 是否是一个平稳时间序列。直观理解,任意给定一个初始值 \(y_0\),经过一段时间后,序列可以稳定下来,即围绕某个固定值以相同的幅度上下波动。

不是所有 AR(1)模型刻画的随机过程都是平稳时间序列:当 AR(1)模型刻画了一个平稳的时间序列,则称 AR(1)模型是平稳的;当 AR(1)模型刻画了一个非平稳的时间序列,则称 AR(1)模型是非平稳的。平稳的 AR(1) 模型才能用于预测。

AR(1)模型平稳性的充要条件是:\(|a_1| < 1\)。

[!Note] 证明:AR(1)模型平稳性的充要条件是:\(|a_1| < 1\)。

首先,我们简单回顾 1.2 平稳性 节对平稳性的介绍:

严平稳太过严格,我们通常考虑弱平稳序列。

弱平稳的定义:当 \(E(y_t)\) 是常数、\(Cov(y_t, y_{t-l})\) 只依赖于 \(l\) 时,时间序列 \(y_t\) 是弱平稳的。

然后,我们开始证明:

1. 充分性: (1)当 \(|a_1| < 1\),我们先考察 \(E(y_t)\) 是否为常数:

\[ y_t = \dfrac{a_0}{1-a_1} + \sum_{i = 0}^{\infty} a_1^i \varepsilon_{t-i} \quad \Rightarrow \quad \mathbb{E}(y_t) = \dfrac{a_0}{1-a_1} \quad (\text{常数}) \]

(2)然后,我们考察 \(|a_1| < 1\) 时的协方差:

\[ \mathbb{Cov}(y_t, y_{t-l}) = \mathbb{Cov}\left(\sum_{i = 0}^{\infty} a_1^i \varepsilon_{t-i}, \sum_{j = 0}^{\infty} a_1^j \varepsilon_{t-l-j}\right) \]

根据协方差的定义,我们可以将其展开为双重求和:

\[ \mathbb{Cov}(y_t, y_{t-l}) = \mathbb{Cov}\left (\sum_{i = 0}^\infty a_1^i \varepsilon_{t-i}, \sum_{j = 0}^\infty a_1^j \varepsilon_{t-l-j}\right) = \sum_{i = 0}^\infty \sum_{j = 0}^\infty a_1^i a_1^j \mathbb{Cov}(\varepsilon_{t-i}, \varepsilon_{t-l-j}) \]

由于 \(\varepsilon\) 是一个方差为 \(\sigma^2\) 的白噪声过程,不同时间的 \(\varepsilon\) 不相关,则协方差项仅在时间点相等时非零(\(=\sigma^2\)),即当 \(t - i = t - l - j\) 时,也就是 \(i = l + j\)。因此,双重求和中只有当 \(i = l + j\) 时才有贡献。将 \(i\) 替换为 \(l + j\),我们得到单重求和:

\[ \mathbb{Cov}(y_t, y_{t-l}) = \sum_{j = 0}^\infty a_1^{l+j} a_1^j \mathbb{Cov}(\varepsilon_{t-l-j}, \varepsilon_{t-l-j})= \sigma^2 \sum_{j = 0}^\infty a_1^{l+2j} = a_1^l \cdot \sigma^2 \sum_{j = 0}^\infty (a_1^2)^j = \frac{a_1^l \sigma^2 }{1-a_1^2} \]

这表明,协方差只依赖于 \(l\),与 \(t\) 无关。如果认为双重求和转化为单重求和太复杂,2.3.3.1 自相关函数(ACF) 还提供了另一种递推的方法。

综上,AR(1)模型在 \(|a_1| < 1\) 时满足弱平稳的定义。

2. 必要性 假设 \(\{y_t\}\) 是平稳时间序列,对 AR(1)公式 \(y_t = a_0 + a_1 y_{t-1} + \varepsilon_t\) 两边取期望得到:

\[ \mathbb{E}(y_t) = a_0 + a_1 \mathbb{E}(y_{t-1}) \quad \Rightarrow \quad \mathbb{E}(y_t) = \frac{a_0}{1 - a_1} \]

两边取方差得到:

\[ \mathbb{Var}(y_t) = \mathbb{Var}(a_0 + a_1 y_{t-1} + \varepsilon_t) = a_1^2 \mathbb{Var}(y_{t-1}) + \mathbb{Var}(\varepsilon_t) + a_1 \mathbb{Cov}(y_{t-1}, \varepsilon_t) \]

- 根据 \(y_t = \frac{a_0}{1 - a_1} + \sum_{i = 0}^∞ a_1^i \varepsilon_{t-i}\),\(y_t\) 完全由 \(t\) 期及以前的冲击决定,进而 \(y_{t-1}\) 完全由 \(t-1\) 期及以前的冲击决定,由于冲击之间的独立性,\(\mathbb{Cov}(y_{t-1}, \varepsilon_t) = 0\);

- 【 非常重要 】基于 \(\{y_t\}\) 平稳的假设,方差在时间上恒定,即 \(\mathbb{Var}(y_t)=\mathbb{Var}(y_{t-1})\)。

- 由此可得到:\[\mathbb{Var}(y_t) = \frac{\sigma_\varepsilon^2}{1 - a_1^2}\]

为了使 \(\mathbb{E}(y_t) = \dfrac{a_0}{1 - a_1}\) 存在且为常数,则要求 \(a_1 \neq 1\) ;

为了使 \(\mathbb{Var}(y_t) = \dfrac{\sigma_a^2}{1 - a_1^2}\) 存在且为正常数,则要求 \(|a_1| < 1\) 。 即 \(\{y_t\}\) 为平稳序列要求 \(|a_1| < 1\)。

1.5.2.3 AR(1)的统计特征

在上一节中我们得到:对于平稳 AR(1)序列 \(y_t = a_0 + a_1 y_{t-1} + \varepsilon_t\) ,有:\(\mathbb{E}(y_t) = \dfrac{a_0}{1 - a_1}\) ,\(\mathbb{Var}(y_t) = \dfrac{\sigma_\varepsilon^2}{1 - a_1^2}\)。其中 \(a_0\) 是截距项,\(a_1\) 是滞后项系数。

当 \(a_0 = 0\) 时,\(\mathbb{E}(y_t) = 0\),这表明没有截距项的 AR(1)模型,时间序列的均值为 0。

当 \(a_1 = 0\) 时,此时时间序列 \(\{y_t\}\) 变为白噪声序列,方差最小;当 \(a_1 ≠ 0\) 时,序列 \(\{y_t\}\) 的方差变大,这说明时间序列 \(\{y_t\}\) 自相关系数越大,时间序列的方差越大,波动越剧烈。

下面,我们考察 AR(1)模型的自相关系数。根据方程,由于 \[ \mathbb{Cov}(y_t, y_{t-l}) = \frac{a_1^l}{1 - a_1^2} \sigma_\varepsilon^2, \] 因此自相关系数(如果忘记了自相关系数,请参阅 1.2 平稳性)为: \[ \rho = \dfrac{\mathbb{Cov}(y_t, y_{t-l})}{\mathbb{Var}(y_t)} = \dfrac{\dfrac{a_1^l}{1 - a_1^2} \sigma_\varepsilon^2}{\dfrac{1}{1 - a_1^2} \sigma_\varepsilon^2} = a_1^l. \] 这说明:当 \(∣a_1∣<1\) 时,弱平稳 AR(1) 序列的自相关函数随滞后阶数 \(l\) 增大而指数衰减。

1.5.3 AR(2)模型

当阶数 \(p = 2\) 时,AR(p) 模型简化为 AR(2) 模型,形式如下:

\[ y_t = a_0 + a_1 y_{t-1} + a_2 y_{t-2} + \varepsilon_t, \quad \varepsilon_t \text{ 是白噪声过程} \]

- 1. AR(2)模型的线性性质: 首先,将 AR(2) 转换为 VAR(1) 形式:

\[ \begin{pmatrix} y_t \\ y_{t-1} \end{pmatrix} = \begin{pmatrix} a_0 \\ 0 \end{pmatrix} + \begin{pmatrix} a_1 & a_2 \\ 1 & 0 \end{pmatrix} \begin{pmatrix} y_{t-1} \\ y_{t-2} \end{pmatrix} + \begin{pmatrix} \varepsilon_t \\ 0 \end{pmatrix} \]

设 \(\mathbf{Y}_t = (y_t, y_{t-1})^\top\),\(\mathbf{u}_t = (\varepsilon_t, 0)^\top\),则方程可改写为:

\[ \mathbf{Y}_t = \mathbf{A}_0 + \mathbf{A}_1 \mathbf{Y}_{t-1} + \mathbf{u}_t \]

向前递推得到:

\[ \mathbf{Y}_t = \mathbf{A}_0 + \mathbf{A}_1 \mathbf{A}_0 + \mathbf{A}_1^2 \mathbf{Y}_{t-2} + \mathbf{A}_1 \mathbf{u}_{t-1} + \mathbf{u}_t = \cdots = (1 - \mathbf{A}_1)^{-1} \mathbf{A}_0 + \mathbf{A}_1^\infty \mathbf{Y}_{t-\infty} + \sum_{i = 0}^\infty \mathbf{A}_1^i \mathbf{u}_{t-i} \]

当矩阵 \(\mathbf{A}_1\) 的特征值都位于单位圆内时,\(\mathbf{A}_1^\infty = 0\),方程可简化为:\[ \mathbf{Y}_t = (1 - \mathbf{A}_1)^{-1} \mathbf{A}_0 + \sum_{i=0}^\infty \mathbf{A}_1^i \mathbf{u}_{t-i} \] 进一步得到 \(y_t\) 的表达式:

\[ y_t = (1, 0)(1 - \mathbf{A}_1)^{-1} \mathbf{A}_0 + \sum_{i=0}^\infty b_i \varepsilon_{t-i} \]

其中 \(b_i = (1, 0)\mathbf{A}_1^i(1, 0)^\top\),即 \(\mathbf{A}_1^i\) 的第 \((1, 1)\) 个元素。 \(\mu = (1, 0)(1 - \mathbf{A}_1)^{-1} \mathbf{A}_0\) 。

- 2. AR(2)模型平稳条件

利用 1.4.5.3 节讲到的滞后算子改写:\(y_t = a_0 + a_1 y_{t-1} + a_2 y_{t-2} + \varepsilon_t\) ,得到: \[ \begin{align*} \Big(1 - a_1 L - a_2 L^2\Big) y_t = A(L) y_t = a_0 + \varepsilon_t \end{align*} \]

其中:\(A(L)\) 称为

AR(2)模型的特征多项式。根据特征多项式得到

AR(2)模型的特征方程:

\[ \begin{align*} A(x) = 1 - a_1 x - a_2 x^2 = 0 \end{align*} \]

不对啊!这和我们前面 1.4.4 节讲的不一样!在 1.4.4 节中,我们要求特征根在单位圆内!

- 这里用词很讲究:“特征方程的根”而不是“特征根”!

- 1.4.4 节中,特征根对应的特征方程和这个不一样!当时我们的特征方程是:\(\lambda^2 - p\lambda - q = 0\)。这里的特征方程可以看作是 \(x=\dfrac{1}{\lambda}\) 的改写。所以,这里的特征方程应该被叫做 “逆特征方程”。

- 本质上讲,在这里,滞后算子 \(L\) 的影响相当于整体除以 \(y_t\)。而在 1.4.4 节,我们的整体除以 \(y_{t-2}\)!(对于 AR(p),1.4.4 节的方法是整体除以 \(y_{t-p}\))。

AR(2)平稳的充要条件为: AR(2)模型的特征根均在单位圆内。

【或者】:AR(2)模型平稳的充要条件是:AR(2)模型的逆特征方程的根全在单位圆外。

[!Excercise] 考虑四组 \(\{a_1, a_2\}\) 组合下的 AR(2) 过程平稳性:

- \(a_1 = 0.4, a_2 = 0.5\)

- \(a_1 = -0.6, a_2 = 0.5\)

- \(a_1 = 0.7, a_2 = -0.1\)

- \(a_1 = 1.2, a_2 = -0.8\)

1.5.4 AR(p)模型

我们先写出 AR(p) 模型的形式,然后分析它的线性特征和平稳性特征:

\[ \begin{split} y_t &= a_0 + a_1 y_{t-1} + a_2 y_{t-2} + \cdots + a_p y_{t-p} + \varepsilon_t \\ &= a_0 + \sum_{i = 1}^{p} a_i y_{t-i} + \varepsilon_t \notag \end{split} \]

- 线性特征:类似于 AR(2),最后递推得到:

\[ y_t = \mathbf{A}_0 (I_p - \mathbf{A}_1)^{-1} + \mathbf{A}_1^\infty y_{t-\infty} + \sum_{i = 0}^\infty \mathbf{A}_1^i \boldsymbol{u}_{t-i} \]

当特征根均在单位圆内时,为线性时间序列。

- 平稳性:

- AR(p) 模型的特征多项式:

\[ A(L) = 1 - a_1 L - a_2 L^2 - \cdots - a_p L^p \]

- AR(p) 模型对应的逆特征方程:

\[ A(L) = 1 - a_1 L - a_2 L^2 - \cdots - a_p L^p = 0 \]

- AR(p) 模型平稳的充要条件:

\[ 1 - a_1 L - a_2 L^2 - \cdots - a_p L^p = 0 \]

逆特征方程的所有根均位于 单位圆外(模长 > 1)。 或通过变量替换 \(x = 1/L\),方程改写为

\[ x^p - a_1 x^{p-1} - \cdots - a_p = 0 \]

要求所有特征根均位于 单位圆内(模长 < 1)。

Chapter 2: 平稳时间序列模型

[!IMPORTANT] 本章学习目标

阐述随机线性差分方程理论。

拓展在估计 ARMA 模型中使用的工具。

考察平稳和非平稳模型的时间序列性质。

考察多种统计检验方法来检验模型的充分性。文中举了几个例子,详细地分析了估计出的 AR-MA 模型,并说明如何运用恰当的已估模型进行预测。

推导不同 ARMA 过程的理论自相关函数。

推导不同 ARMA 过程的理论偏自相关函数。

阐述 Box-Jenkins 方法在模型选择过程中是怎样依赖于自相关和偏自相关的,

扩展 Box-Jenkins 模型选择工具的完备集。

检验时间序列预测的性质。

以利率期限结构模型为例证明 Box-Jenkins 方法。

阐述模型序列如何包含季节因素。

扩展模型精确度的诊断性检验。

阐述组合预测为何明显优于单个模型的预测。

2.1 随机差分方程模型

目标:模拟动态经济过程

2.1.1 白噪声过程

白噪声(white-noise)过程是一种特殊的时间序列模型,对应的是纯随机序列。

[!Note] 定义:白噪声 若序列中每个元素均值都为零,同时具有同方差,且与所有其他的实现值之间不存在自相关,则序列 \({\varepsilon_t}\) 为白噪声过程。

白噪声过程的统计特征:零均值,同方差,无自相关(协方差为 0)。对于正态分布而言,不相关即可推出独立,所以如果该白噪声如果服从正态分布,则其还将互相独立。

根据 白噪声过程的统计特征,我们可以得到:如果序列 \({\varepsilon_t}\) 为白噪声过程,有:

【零均值】:若符号 \(E(x)\) 代表 \(x\) 的理论均值,对每个时期 \(t\),有:

\[ E(\varepsilon_t)=E(\varepsilon_{t-1})=\cdots=0 \]

【同方差】:用 \(Var(x)\) 代表 \(x\) 的方差,对每个时期 \(t\),有:

\[ \operatorname{Var}(\varepsilon_t)=\operatorname{Var}(\varepsilon_{t-1})=\cdots=\sigma^2 \]

或者,由于 \(Var(x)= E(x^2)- [E(x)]^2\) ,结合零均值特征 \(E(x)≡0\),有:

\[ E(\varepsilon_t^2)=E(\varepsilon_{t-1}^2)=\cdots=\sigma^2 \]

【无自相关(协方差为 0)】 对所有的 \(j\) 和 \(s\),有:

\[ \operatorname{Cov}(\varepsilon_t,\varepsilon_{t-j})=\operatorname{Cov}(\varepsilon_{t-j},\varepsilon_{t-j-s})=0 \]

或者,由于 \(Cov(x,y)=E(xy)-E(x)E(y)\),结合零均值特征 \(E(x)=E(y)=0\),有:

\[ E(\varepsilon_t\varepsilon_{t-j})=E(\varepsilon_{t-1}\varepsilon_{t-j-s})=0 \]

[!Tip] 思考:白噪声 是平稳过程吗? (提示:结合 1.2 平稳性 对于时间序列弱平稳的讨论)

- 均值恒定:\(E(y_t) = \mu\)(各时期数学期望恒定)

- 方差恒定:\(\text{Var}(y_t) = \sigma^2\)(各时期方差恒定)

- 协方差仅依赖时间间隔(而不随时间变化):\(\text{Cov}(y_i, y_j) = \gamma_{|i-j|}\)(任意两时期的协方差仅与时间间隔绝对值有关)

我们发现,白噪声符合以上三个要求,白噪声是平稳过程。

事实上,白噪声序列一定是平稳序列, 而且是最简单的平稳序列。若给定时间序列是白噪声序列,则无需预测。

2.1.2 移动平均模型(MA)

现在,我们用白噪声过程来构造移动平均模型(MA 模型)。MA 模型基于白噪声序列的假设,描述的是当前时间点的数据与过去噪声的关系。

2.1.2.1 移动平均模型是什么?

移动平均模型(MA)的 核心思想 是:我们可以把一个时间序列看作是过去若干期噪声的加权平均,即当前的观察值是由过去的白噪声通过一定的线性组合得到的。

即,MA(q)模型可以写成:

\[ x_t = \beta_0 \varepsilon_t + \beta_1 \varepsilon_{t-1} + \cdots +\beta_q \varepsilon_{t-q} = \sum_{i = 0}^{q} \beta_i \varepsilon_{t-i} \notag \]

对任意时期 \(t\),对 \(\varepsilon_t\),\(\varepsilon_{t-1}\),…,\(\varepsilon_{t-q}\) 依次取值并乘以对应的 \(\beta_i\) 即可计算出 \(x_t\),我们把这样的序列称为 \(q\) 阶移动平均(moving average),用 MA \((q)\) 表示。

- \(x_t\) 是我们感兴趣的时间序列在时间点 \(t\) 的观察值。

- \(\varepsilon_t, \varepsilon_{t-1}, \varepsilon_{t-2}, \dots, \varepsilon_{t-q}\):这些是白噪声项,每个时间点的值都是独立同分布的,通常假设为正态分布。这些项的均值为 \(0\),方差为 \(\sigma^2\)(常数)。\(\varepsilon_t\) 是当前时刻的白噪声,\(\varepsilon_{t-1}\) 是上一时刻的白噪声,依此类推,\(\varepsilon_{t-q}\) 是 \(q\) 个时刻前的白噪声。

- \(\beta_1, \beta_2, \dots, \beta_q\):这些是 MA 模型的参数,每个参数 \(\beta\) 都对应一个白噪声项。它们衡量的是对应的白噪声对当前时间点的影响程度。

- \(q\) 是阶数,表示有多少个过去的白噪声项被纳入模型,指的是在模型中包含的过去白噪声项的数量。例如,如果 \(q=2\),那么模型就包含了 \(\varepsilon_{t-1}\) 和 \(\varepsilon_{t-2}\) 两个白噪声项。

[!Excercise] 练一练:请写出 MA(\(∞\))

【补充】:在一些版本的 MA 模型中,模型被写作

\[ x_t = \mu + \varepsilon_t + \beta_1 \varepsilon_{t-1} + \cdots +\beta_q \varepsilon_{t-q} \notag \]

它较上面模型有两处改变:(1)多包括时间序列的均值或期望值 \(\mu\) ,\(\mu\) 对所有的时间点都是相同的。不加 \(\mu\) 的时间序列可以被视为 已经通过差分或去趋势转换为均值为零 的序列。(2)为方便采用标准化,使 \(\beta_0\) 恒等于 1。

[!Tip] 为什么叫做【移动平均模型】? 移动平均模型(MA)认为:大部分时候时间序列应当是相对稳定的。在稳定的基础上,每个时间点上的值受过去一段时间内、不可预料的各种偶然事件影响而波动。

即在一段时间内,时间序列应该是围绕着某个均值上下波动的序列,时间点上的值会围绕着某个均值移动,因此模型才被称为“移动平均模型“。它的预测值是过去白噪声的加权平均。

[!Note] MA 模型的前提假设 移动平均模型(MA)的基本假设可以从以下几个方面来理解:

平稳性:MA 模型假设时间序列是平稳的。这意味着序列的主要统计属性,如均值和方差,不随时间变化。这个假设强调了序列在长期内保持稳定的行为,而在短期内可能会受到随机因素的影响。

白噪声:MA 模型假设存在一个白噪声序列。白噪声是随机误差项,它的均值为 0,方差为常数,且各个时间点上的值是相互独立的。这个假设强调了在一段较短的时间内,时间序列的波动可能受到不可预测的随机因素的影响。

线性:MA 模型假设时间序列可以被过去的白噪声项的线性组合表示。这就是模型被称为“移动平均”模型的原因,因为它的预测值是过去白噪声的加权平均。

有限历史影响:MA 模型假设只有过去的 q 个白噪声才对当前时间点的值有影响,其中 q 是模型的阶数。换言之,过去更久的白噪声对当前值没有直接影响(如 \(cov(x_t,x_{t-q-1})=0\))。

值的关联性与白噪声的独立性:MA 模型假设不同时间点的值之间是关联的,这反映了历史影响时间序列的长期趋势。而偶然事件在不同时间点上产生的影响(即白噪声)是相互独立的,这反映了在短期内,时间序列的波动可能受到不可预测的随机因素的影响。

【举个例子】:影响明日会不会下雨的真正因素并不是“今天”或“昨天”这些时间概念本身,而是风、云、日照等更加客观和科学的因素(这些其实就是 MA 模型认为的“偶然因素”)。不过也能够理解,随着季节的变化、时间自有自己的周期,因此天气也会存在季节性的周期,因此从长期来看时间序列的趋势是恒定的。

2.1.2.2 MA(q) 的平稳性

我们先展示结论:

[!Note] MA(q) 的平稳性:

- 当 \(q\) 为有限值时,MA(q) 一定是平稳过程。

- 当 \(q \to \infty\)(无穷阶 MA),若对任意 \(s\) 有 \(\beta_0 + \beta_1 \beta_{s+1} + \beta_2 \beta_{s+2} + \cdots\) 收敛,则 MA(\(\infty\)) 也是平稳过程。

下面我们为上述结论给出证据。我们的逻辑是:先针对 MA(1)、MA(2) 的情况讨论,然后外推。

【MA(1) 的平稳性】:考虑 MA(1):\(x_t = \beta_0 \varepsilon_t + \beta_1 \varepsilon_{t-1}\)

为体现一般性,我们考虑未经过【去趋势 \(\mu=0\) 】和【标准化校准 \(\beta_0=1\) 】 的 MA(1)。

\[ x_t = \mu + \beta_0 \varepsilon_t + \beta_1 \varepsilon_{t-1} \notag \]

结合 1.2 平稳性 对于时间序列弱平稳的讨论,我们要说明 MA(1) 平稳,就要证明其满足:

- 均值恒定:\(E(x_t) = \mu\)(各时期数学期望恒定)

- 方差恒定:\(\text{Var}(x_t) = \sigma^2\)(各时期方差恒定)

- 协方差仅依赖时间间隔(而不随时间变化):\(\text{Cov}(x_i, x_j) = \gamma_{|i-j|}\)(任意两时期的协方差仅与时间间隔绝对值有关)

(1)均值恒定

通过对 MA(1) 左右两边同时取期望,我们得到: \(E(x_t) = \mu + \beta_0 E(\varepsilon_t)+ \beta_1 E(\varepsilon_{t-1})\) 。回忆 2.1.1 白噪声过程 中白噪声的统计特征,\(E(\varepsilon_t)=E(\varepsilon_{t-1})≡0\),因此有: \(E(x_t) = \mu\) 为常数。

(2)方差恒定

然后,我们考虑方差是否恒定。我们得到:\(Var(x_t) = \beta_0^2Var(\varepsilon_t) + \beta_1^2 Var(\varepsilon_{t-1})\) 。回忆 2.1.1 白噪声过程 中白噪声的统计特征 \(Var(\varepsilon_t)=Var(\varepsilon_{t-1})=\sigma^2\),因此得到: \(Var(x_t) = (\beta_0^2+\beta_1^2)\sigma^2\) 为常数。

(3)协方差不随时间变化

自协方差函数 \(\gamma_l = Cov(x_t, x_{t-l}) = Cov(\mu+\beta_0 \varepsilon_t+\beta_1\varepsilon_{t-1}, \mu + \beta_0 \varepsilon_{t-l} + \beta_1\varepsilon_{t-l-1})\)

- 当 \(l=0\) 时,实际上就讨论了方差是否恒定:

\[ \gamma_0 = Var(x_t) = \beta_0^2Var(\varepsilon_t) + \beta_1^2 Var(\varepsilon_{t-1}) = (\beta_0^2+\beta_1^2)\sigma^2 \quad (\text{存在且为常数}) \]

- 当 \(l=1\) 时,由 2.1.1 白噪声过程 中白噪声的统计特征,\(Cov(\varepsilon_t,\varepsilon_{t-l})=0\) ,有:

\[ \begin{split} \gamma_1 = Cov(x_t, x_{t-1}) &= Cov(\beta_0 \varepsilon_t+\beta_1\varepsilon_{t-1}, \beta_0 \varepsilon_{t-1}+\beta_1\varepsilon_{t-2}) \\ &=\beta_0^2 Cov(\varepsilon_t,\varepsilon_{t-1})+ \beta_0 \beta_1 Var(\varepsilon_{t-1})+\beta_0 \beta_1 Cov(\varepsilon_t,\varepsilon_{t-2}) + \beta_1^2 Cov(\varepsilon_{t-1},\varepsilon_{t-2})\\ &= \beta_0 \beta_1 \sigma^2 \quad (\text{存在且为常数}) \end{split} \]

- 当 \(l \geq 2\) 时,这时 \(l > q\)。基于 MA 模型的有限历史影响,过去更久的白噪声对当前值没有直接影响,\(\gamma_l = Cov(x_t, x_{t-l}) = 0 \quad (\text{存在且为常数})\)

【MA (2) 的平稳性】:设 MA (2) 过程为:

\[ x_t = \mu + \beta_0 \varepsilon_t + \beta_1 \varepsilon_{t-1} + \beta_2 \varepsilon_{t-2} \]

其中 \(\varepsilon_t\) 是白噪声过程,满足 \(E(\varepsilon_t)=0\), \(Var(\varepsilon_t)=\sigma^2\), \(Cov(\varepsilon_t,\varepsilon_{t-l})=0\)。

(1)均值恒定

对 MA (2) 两边取期望:\(E(x_t) = E(\mu) + \beta_0 E(\varepsilon_t) + \beta_1 E(\varepsilon_{t-1}) + \beta_2 E(\varepsilon_{t-2}) = \mu \quad (\text{常数})\)

(2)方差恒定

计算方差: \(Var(x_t) = \beta_0^2 Var(\varepsilon_t) + \beta_1^2 Var(\varepsilon_{t-1}) + \beta_2^2 Var(\varepsilon_{t-2}) = (\beta_0^2 + \beta_1^2 + \beta_2^2)\sigma^2 \quad (\text{常数})\)

(3)协方差不随时间变化

考虑自协方差函数,滞后阶数 \(l\) :

- \(l=0\) 时,实际上就讨论了方差是否恒定: \(\gamma_0 = Var(x_t) = (\beta_0^2 + \beta_1^2 + \beta_2^2)\sigma^2 \quad (\text{常数})\)

- \(l=1\) 时,由 2.1.1 白噪声过程 中白噪声的统计特征,\(Cov(\varepsilon_t,\varepsilon_{t-l})=0\) ,有:

\[ \begin{aligned} \gamma_1 &= Cov(x_t, x_{t-1}) = Cov(\beta_0 \varepsilon_t + \beta_1 \varepsilon_{t-1} + \beta_2 \varepsilon_{t-2}, \beta_0 \varepsilon_{t-1} + \beta_1 \varepsilon_{t-2} + \beta_2 \varepsilon_{t-3}) \\ &= \beta_0\beta_1 Var(\varepsilon_{t-1}) + \beta_1\beta_2 Var(\varepsilon_{t-2}) \\ &= (\beta_0\beta_1 + \beta_1\beta_2)\sigma^2 \quad (\text{常数}) \end{aligned} \]

- \(l=2\) 时: \(\gamma_2\) 为常数:

\[ \gamma_2 = Cov(x_t, x_{t-2}) = Cov(\beta_0 \varepsilon_t + \beta_1 \varepsilon_{t-1} + \beta_2 \varepsilon_{t-2}, \beta_0 \varepsilon_{t-2} + \beta_1 \varepsilon_{t-3} + \beta_2 \varepsilon_{t-4}) = \beta_0\beta_2\sigma^2 \]

- \(l≥3\) 时,这时 \(l > q\)。基于 MA 模型的有限历史影响,过去更久的白噪声对当前值没有直接影响,\(\gamma_l = Cov(x_t, x_{t-l}) = 0\) ,存在且为常数。

[!Note] 【外推:MA(q) 的平稳性】: 【思考】 请借助前面的 MA(1) 和 MA(2) 找规律,给出 MA(q) 的均值、方差、协方差。

MA (q) 模型的平稳性 (有限阶移动平均过程)

\[ x_t = \mu + \sum_{i=0}^q \beta_i \varepsilon_{t-i} \]

- 均值:\(E(x_t)=\mu\)

- 方差:\(Var(x_t)=\sigma^2 \sum_{i=0}^q \beta_i^2\)

- 协方差:\(Cov(x_t,x_{t-l})=\sigma^2 \sum_{i=l}^q \beta_i \beta_{i-l} \quad (l \leq q)\)

平稳性结论 :由于求和项为有限项,MA (q) 过程始终满足均值恒定、方差有限恒定、协方差仅依赖时间间隔,因此 当 \(q\) 为有限值时,MA (q) 总是平稳的

那么,当 \(q \to \infty\)(无穷阶 MA) 呢?

[!Tip] 【外推:MA (∞) 的平稳性】 无限 MA 过程 (无穷阶移动平均过程)

\[ x_t = \mu +\sum_{i=0}^\infty \beta_i \varepsilon_{t-i} \]

- 均值:\(E(x_t)=\mu\)

- 方差:\(Var(x_t)=\sigma^2 \sum_{i=0}^\infty \beta_i^2\)

- 协方差:\(Cov(x_t,x_{t-l})=\sigma^2 \sum_{i=l}^\infty \beta_i \beta_{i-l}\)

平稳性条件 :当且仅当系数平方和与交叉项均收敛时,无限 MA 过程平稳。

\[ \sum_{i=0}^\infty \beta_i^2 < \infty \qquad \sum_{i=l}^\infty \beta_i \beta_{i-l} < \infty \]

通过 柯西不等式,若系数平方和收敛,则系数交叉项均收敛:

\[ \left| \sum_{i=0}^\infty \beta_i \beta_{i-l} \right| \leq \sqrt{ \sum_{i=0}^\infty \beta_i^2 } \cdot \sqrt{ \sum_{i=0}^\infty \beta_{i-l}^2 } < \infty \]

因此,仅需系数平方和收敛(即:平方可加)即可保证平稳性。

为方便起见,通常使用比平方可加略强的条件:绝对可加(\(\sum_{i=0}^\infty |\beta_i| < \infty\))。关于二者的关系,请参考《Time Series Analysis》(Hamilton, 1994) 英文版第 52 页。如果使用中国人民大学出版社出版的中文版,这部分内容在第 59-60 页。

你可能会疑惑:这里我们的总体思路与课本一致,但为什么结论似乎有所不同。在课本(中文版第 45 页)中,任意 MA 过程平稳的充分必要条件除了平方和收敛外,还有当 \(q \to \infty\),若对任意 \(l\) 有 \(\beta_0 + \beta_1 \beta_{l+1} + \beta_2 \beta_{l+2} + \cdots +\beta_i \beta_{i+l} + \cdots\) 收敛。事实上,我们把 \(i\) 视作 \(i-l\) 即可。

2.1.2.3 MA(q) 与 AR (p) 的比较

虽然在形式上,AR(自回归)模型和 MA(移动平均)模型看起来很相似,但是他们的关键区别在于他们对过去信息的处理方式。

- 对于自回归(AR)模型:当前值是过去值的函数。也就是说,我们是在使用过去的 “实际” 观察值来预测现在的值。AR 模型的基本思想是过去的观测值会对未来的观测值产生影响,即未来的观测值是过去观测值的加权和。

- 对于移动平均(MA)模型:当前值是过去噪声(或称之为误差或冲击)的函数。这里的“白噪声”实际上是模型无法解释的随机部分,是未能被模型捕获的信息。换句话说,MA 模型是在试图用过去的 “错误” 或 “冲击”(即预测值 \(\hat{Y}\) 和真实值 \(Y\) 之差,也就是残差 Residuals)来预测现在的值。

- 关于二者的互推问题,请参考 1.5.2.1 AR(1)的线性特征(#1.5.2.1%20AR(1) 的线性特征) 和 2.3.5.2 可逆性 的推导。

2.2 自回归移动平均模型(ARMA)

2.2.1 Wold 分解定理

Wold 分解定理:对于任意平稳序列,可以分解成过去序列值的线性组合和纯随机序列。即对于 \(X_t\),存在如下分解:

\[ X_t = \sum_{k = 1}^{\infty} a_k X_{t-k} + E_t \]

其中 \(E_t\) 相互独立且不可预测。结合相关性假设,如果 \(a_k\) 全为 \(0\),那么 \(X_t\) 就不存在相关性,是纯随机序列,那就不用研究了。

其中 AR 模型 是把随机部分简化,保留历史序列部分;那么对偶地,MA 模型 是将历史序列值简化,保留随机部分。

2.2.2 自回归移动平均模型是什么?

2.2.2.1 ARMA 模型定义

将移动平均过程和线性差分方程合并,便可得到自回归移动平均(ARMA)模型。考察 p 阶差分方程

\[ y_t = a_0 + \sum_{i = 1}^{p} a_i y_{t-i} + x_t \]

现令 \(\{x_t\}\) 表示 MA(q) 过程,则有 ARMA 模型:

\[ y_t = a_0 + \sum_{i = 1}^{p} a_i y_{t-i} + \sum_{i = 0}^{q} \beta_i \varepsilon_{t-i} \tag{*} \]

为了方便,我们采用标准化,使 \(\beta_0\) 恒等于 1。

如果方程的特征根均在单位圆以内,称为 \(y_t\) 的 自回归移动平均(Autoregressive Moving-average,ARMA)模型。

- ARMA 模型的 自回归部分 是齐次部分所给出的差分方程,移动平均部分 为序列 \(\{x_t\}\)。

- 如果差分方程的齐次部分滞后期为 p,并且 \(\{x_t\}\) 的滞后期为 q,那么,我们把这个模型称为 ARMA(p,q) 模型。

- 若 q = 0,则把这个过程称为纯自回归过程,用 AR(p)表示;

- 若 p = 0,则这个过程被称为纯移动平均过程,用 MA(q)表示。

- 在 ARMA 模型中,完全允许 p 和(或)q 取无穷大。

本章中,我们只考察 所有特征根都在单位圆内 的情况。然而,如果有一个或多个特征根大于或等于 1,则称序列 \(\{y_t\}\) 为积分(integrated)过程,这时的方程(\(*\))称为 自回归求积移动平均(ARIMA)模型 。

2.2.2.2 求解 ARMA(p, q)

把 ARMA 看作差分方程,意味着我们能够解出 \(y_{t}\),它是用序列 \(\{\varepsilon_{t}\}\) 表示的。我们把 ARMA(p, q)模型以序列 \(\{\varepsilon_{t}\}\) 表示的解 \(y_{t}\) 称为 \(y_{t}\) 的 移动平均表达式(moving-average representation),这个求解过程与 1.4 差分方程的求解方法 所讨论的类似。

对于 AR(1)模型 \(y_{t}=a_0+a_1y_{t-1}+\varepsilon_{t}\),正如我们在 1.4.2.1 迭代法 讨论的,它的移动平均表达式为 MA(\(∞\)):【请回忆,我们曾在 2.1.2 移动平均模型(MA) 中练习过 MA(\(∞\)) 】

\[ y_{t}=\frac{a_0}{1-a_1}+\sum_{i = 0}^{\infty} a_i^i\varepsilon_{t-i} \]

对于一般的 ARMA(p, q)模型,用滞后算子重写 \((*)\),变为

\[ \left( 1-\sum_{i = 1}^{p} a_iL^i\right)y_t = a_0+\sum_{i = 0}^{q} \beta_i\varepsilon_{t-i} \]

所以,\(y_{t}\) 的特解为

\[ y_{t}=\frac{a_0+\sum_{i = 0}^{q} \beta_{i} \varepsilon _{t-i}}{1-\sum_{i = 1}^{p} a_{i} L^{i}} \]

幸运的是,我们不必使用待定系数法展开来求得序列 \(\{\varepsilon_{t}\}\) 中每个元素的具体系数。但是我们必须认识到:这一展开式会生成 MA(\(\infty\))过程。

注:如果对本小节涉及的滞后算子计算不熟悉,还请回顾 1.4.5.3 滞后算子;如果对其中涉及的特征多项式、特征方程、特征根有疑问,可以回顾 1.4.4 高阶齐次解:特征根 。

2.2.2.3 ARMA(p, q) 的平稳性

在上一节的讨论中,我们认识到:ARMA 模型只有在保持 AR (p) 和 MA (q) 都平稳的情况下才会平稳。关于平稳性的内容,还请回顾 1.2 平稳性、1.5.2.2 AR(1)的平稳性(#1.5.2.2%20AR(1) 的平稳性)、1.5.3 AR(2)模型(#1.5.3%20AR(2) 模型) 和 1.5.4 AR(p)模型(#1.5.4%20AR(p) 模型)。

- 正如我们在 1.5.4 AR(p)模型(#1.5.4%20AR(p) 模型) 中看到的,AR (p) 平稳的条件是特征多项式 \((1-\sum_{i=1}^{p} a_iL^i)\) 的根在单位圆之外。(或者说,逆特征方程的根在单位圆之外,or 特征根在单位圆内。)

- 我们在 2.1.2.2 MA(q) 的平稳性(#2.1.2.2%20MA(q)%20 的平稳性) 中也曾讨论过,MA(q) 在 \(q\) 为有限值时一定是平稳过程,在 \(q \to \infty\)(无穷阶 MA)时,若平方可加,也是平稳过程。

因此,ARMA 过程的平稳性完全取决于自回归参数,而与移动平均参数无关。ARMA (p, q) 的平稳性取决于 AR(p) 的平稳性,只要特征根在单位圆内,ARMA 过程就是平稳的。

2.3 时间序列模型的使用

2.3.1 使用时间序列模型的流程

现在,我们已经对 ARMA 模型有了一定的了解,那么接下来,我们就以比较直观的 GDP 序列来考虑 如何使用时间序列模型。比如,我们会问:我现在已经获得了 2000-2020 年的 GDP 数据,我怎么使用 ARMA 模型预测?

表面上看,这个问题好像很具体;但事实上,这个问题包含了很多时间序列分析的细节:在使用模型前我应该如何预处理?我应当选取哪种模型?模型应该使用多少期的滞后?如何估计模型的参数?我怎么知道自己预测的效果好不好呢?

这张时间序列分析流程图给予了我们一些启发。我们可以大致把问题分成下面几部分:

- 时间序列的 预处理 。

- 选择适当的模型进行识别。这包含两方面:

- 只有数据的我们不知道模型是否适当,因此需要尝试并比较。

- 一方面,模型能否使用?有没有分析的价值?——这涉及第 3 章的平稳性检验。

- 另一方面,比较的标准是什么?——这就涉及到后面关于预测效果的问题。

- 对于每一种尝试的模型,都需要 定阶 (也就是选取滞后期数)。比如,AR(p) 的 p 取多少合适?

- 只有数据的我们不知道模型是否适当,因此需要尝试并比较。

- 模型的 参数估计方法 。

- 检验、比较各个模型的 预测效果 。这涉及了模型筛选和预测评价。

更多内容请参考:时间序列预处理

2.3.2 时间序列的预处理

流程图表明,在模型识别前,我们应当的输入需要是平稳的非白噪声的序列。这就需要我们进行预处理。本节展示预处理的常见方法。

应对缺失值。 面对缺失数据,我们应当基于前后数据补全,一种比较常见的方法是线性插值(linear interpolation)。公式是:假设 \(i<j\),\(t ∈ (t_i,t_j)\) ,则 \(y = y_i + \dfrac{t - t_i}{t_j - t_i} \cdot (y_j - y_i)\)。插值过程中也可以使用更复杂的方法进行拟合。

处理时序数据噪声。有时候,我们需要去除短时间内的数据扰动(short-term fluctuations)。一个办法是装箱(Binning),将时间序列按照一定间隔分组(如间隔 𝑘),使用均值代替原始的 𝑘 个值。

时间序列的归一化、标准化。

- 这涉及时序数据在尺度(scale)上的变化,以及时序数据的平移(translation)变化。

- 我们的目标是:对于任意尺度常数 \(a\) 和平移常数 \(b\),时间序列的线性变换 \(ax+b\) 不影响其相似度的计算。

- 归一化 (Normalization): 将时序数据取值限制在 \([0,1]\) 区间内。归一化的公式是: \[y_t^{\prime} = \dfrac{y_t - y_{\text{min}}}{y_{\text{max}} - y_{\text{min}}}\]

- 标准化 (Standardization):将时序数据的分布变换为均值为 0、标准差为 1 的形式。标准化的公式是: \[z_t = \dfrac{y_t - \mu}{\sigma}\]

- 平均归一化 (Mean Normalization):\(y_t^{\prime} = \dfrac{y_t - \mu}{y_{\text{max}} - y_{\text{min}}}\)

其他的时间序列预处理方法:

- 时间序列的分解:季节项 \(S_t\) 刻画时间序列的周期性变换,趋势项

\(T_t\)

刻画序列的整体变化趋势;剩余项记为 \(R_t\)。

- 相加分解(additive decomposition) \(y_t= S_t + T_t + R_t\)

- 相乘分解(multiplicative decomposition) \(y_t= S_t × T_t × R_t\)

- 对数变换:针对变化程度建模,使高偏度的分布变得不那么偏斜。

- Box-Cox 变换:用于分布“正态”程度的矫正(针对取值非负的序列)。

- Tukey Ladder of Powers:用于将有偏的分布“矫正”,趋向于正态分布(辅助概率化建模)

- 时间序列的分解:季节项 \(S_t\) 刻画时间序列的周期性变换,趋势项

\(T_t\)

刻画序列的整体变化趋势;剩余项记为 \(R_t\)。

2.3.3 Box-Jenkins 模型筛选:定阶

在完成预处理后,一个重要的步骤是 平稳性检验 。与我们在 2.2.2.3 ARMA(p, q) 的平稳性(#2.2.2.3%20ARMA(p,%20q)%20 的平稳性) 中的分析一致,若 \(a_1\) 的估计值接近 1,则应该怀疑 AR (1) 模型的可靠性;而对于 ARMA(2, q) 模型,特征多项式的根应在单位圆之外。对于非平稳性序列,也有大量文献提出检验方法,因此,序列平稳性检验的讨论将被放在第 3 章进行。而目前,我们就先假设都使用平稳数据。

在检验数据平稳性之后,下一步要做的就是 建模 了。我们接下来介绍一种普及的、用于估计和预测单个时间序列的宏观步骤—— Box-Jenkins 模型筛选方法。

Box-Jenkins 方法是美国学者 Box 和英国学者 Jenkins 于 20 世纪 70 年代提出的关于时间序列、预测及控制的一整套方法,也称作传统的时间序列建模方法。它将时间序列建模分为三个阶段:识别阶段 (identifcation stage)、估计阶段 (estimation stage) 和诊断检验阶段 (diagnostic checking)。

- 在 识别阶段 ,研究者实际上是检査时间序列的 散点图 、 自相关函数 、 偏自相关函数 ,从而初步为模型定阶。

- 在 估计阶段 ,需要对每个试验模型进行拟合,并且对多个 \(\alpha\) 和 \(\beta\) 系数进行检验。选择一个能较好拟合的并且固定简约的模型是这一阶段的目标。

- 在 诊断检验阶段 ,我们要检验确保估计模型的残差能够模拟白噪声过程。

我们首先来看第一阶段,也就是为模型初步 定阶。自然地,我们会问:什么是 “定阶”?很容易理解,“定阶” 就是确定阶数。关于模型的阶数,我们在 1.5.4 AR(p)模型(#1.5.4%20AR(p) 模型) 和 2.1.2.1 移动平均模型是什么? 中都有所提及。对于 AR(p) 模型,求解阶 p 的问题叫作 AR 模型的定阶;对于 MA (q) 模型,求解阶 q 的问题就叫作 MA 模型的定阶。

定阶的常用方法有两种:偏自相关函数(PACF) 和 信息准则 。我们接下来逐一介绍它们。

2.3.3.1 自相关函数(ACF)

在介绍偏自相关函数(PACF)之前,我们先来认识自相关函数(ACF)。

让我们仔细关注一下 “自相关函数” 这个新术语。似乎不用过多解释,看上去好像就有点理解了。但这很可能是我们的错觉:我们自然而然地联想到的是 自相关系数,而不是 自相关函数。

[!NOTE] 回顾:关于自相关系数

在我们初识数理统计的时候,我们最先接触的是单变量的均值(衡量集中趋势)和方差(衡量离散程度),它们分别是一阶原点矩和二阶中心矩。矩是一种数学计算方式,矩的数学本质是期望,一个变量的 K 阶矩就是这个变量的 K 次方的均值。在此基础之上,可以扩展出原点矩,中心矩,绝对矩等。三阶中心距(偏度)衡量对称程度,四阶中心距(峰度)衡量尾部厚度。

当我们在考虑两个变量的关系时,我们常常考虑的是 协方差。协方差是两个变量的二阶混合中心矩,测量两个变量之间的同步性,公式为: \(\operatorname{cov}(X, Y)=E\left[\left(X-\mu_{x}\right)\left(Y-\mu_{y}\right)\right]=E(X Y)-\mu_{x} \mu_{y}\)。可以发现,协方差的大小与两个变量的大小有关。为了无量纲化,我们对其进行标准化处理:由于协方差公式中已经隐含了减去均值的操作,只需要除以两个变量各自的标准差,就得到了 相关系数。相关系数具有尺度不变性,能准确度量两个变量之间线性关系的强度。

在时间序列分析中,我们关心同一变量在不同时点之间的相关性,我们将不同时点的同一变量视为两个变量,计算出的相关系数就是自相关系数。自相关系数反映了序列内部的依赖关系,假设时间序列为 \(\{Y_t\}\),滞后 \(l\) 期的自相关系数 \(\rho_l\) 定义为:

\[ \rho_l = \dfrac{\text{Cov}(Y_t, Y_{t-l})}{\sqrt{\text{Var}(Y_t) \cdot \text{Var}(Y_{t-l})}} \]

如果时间序列是平稳的(方差不变),公式可简化为:

\[ \rho_l = \frac{\text{Cov}(Y_t, Y_{t-l})}{\text{Var}(Y_t)} \]

由于平稳性检验的方法丰富,教材专门开辟了一个章节(第 3 章)来分析。我们简要剧透一下:平稳的时间序列和单位根非平稳时间序列是值得研究的,而其他不平稳时间序列不常见也不值得研究。在这里,我们只讨论平稳的时间序列。

那么,什么是自相关函数呢?自相关函数与自相关系数又是什么关系呢?

自相关函数(ACF)的定义: 自相关函数描述了 时间序列在不同滞后期数(Lag)下的相关性 ,即序列与其自身滞后值之间的线性相关程度。它衡量了当前值与过去值之间的关系。

定义表明,自相关函数体现的是自相关系数 \(\rho\) 和滞后期数 \(l\) 之间的对应关系。就像微观经济学中需求函数对应需求曲线一样,自相关函数对应的是 自相关图 (correlogram)。若序列平稳,自相关函数(或自相关图)应在几何意义上收敛于 0。很容易理解,序列平稳本身就意味着伴随时间推移趋于收敛,距离时间越久,相关性也相应越低,最后会趋于无影响。

为了进一步加深理解,我们接下来考察 AR (1) 过程的自相关函数。

[!tip] AR (1) 过程的自相关函数 (ACF)

AR(1) 模型:\(y_t = a_0 + a_1 y_{t-1} + \varepsilon_t\)

当其满足平稳的必要条件 \(|a_1|<1\) 时(所以说,自相关系数是在平稳条件下求得的):

- \(y_t\) 和 \(y_{t-l}\) 的方差是有限常数,

\[ \gamma_0 = Var(y_t) = a_1^2 Var(y_{t-l}) + \sigma^2 = \dfrac{\sigma^2}{1-a_1^2} \]

- \(y_t\) 和 \(y_{t-l}\) 的协方差记为 \(\gamma_l\)。我们在 1.5.2.2 AR(1)的平稳性(#1.5.2.2%20AR(1) 的平稳性) 中曾推导过。如果认为双重求和转化为单重求和太复杂,下面还提供了另一种递推的方法。

\[ \gamma_1 = Cov(y_t,y_{t-1}) = Cov(a_1 y_{t-1} + \varepsilon_t, y_{t-1}) = a_1 Cov(y_{t-1},y_{t-1}) + Cov(\varepsilon_t, y_{t-1})=a_1 \gamma_0 \]

推导的过程中一定要注意,\(Cov(y_{t-1},y_{t-1})=Var(y_{t-1}) = \gamma_0 \neq \sigma^2\) , \(Var(\varepsilon)\) 才等于 \(\sigma^2\)

基于 AR(1) 模型,我们可以递推得到 \(y_{t-1} = a_0 + a_1 y_{t-2} + \varepsilon_{t-1}\),得:

\[ \gamma_2 = Cov(y_t,y_{t-2}) = Cov(a_1 y_{t-1}, y_{t-2}) = a_1 Cov(y_{t-1},y_{t-2})= a_1 Cov(a_1 y_{t-2},y_{t-2}) =a_1^2 \gamma_0 \]

继续递推,得到:

\[ \begin{split}\gamma_l = Cov(y_t, y_{t-l}) & = a_1 Cov(y_{t-1}, y_{t-l})= a_1^2 Cov(y_{t-2}, y_{t-l})= \cdots = a_1^l Cov(y_{t-l}, y_{t-l}) \\ &= a_1^l \gamma_0 = \dfrac{a_1^l \sigma^2}{1-a_1^2}\end{split} \]

由 \(\rho_l = \dfrac{\text{Cov}(Y_t, Y_{t-l})}{\text{Var}(Y_t)}\) ,ACF 有: \(\rho_0 = 1, \quad \rho_1 = a_1, \quad \rho_2 = a_1^2, \quad \cdots, \quad \rho_l = a_1^l\)

由于 \(\{\rho_i\}\) 的平稳条件为 \(|a_1| <1\) ,所以 \(0<a_1<1\) 则自相关系数直接收敛到 0,\(-1<a_1<0\) 则自相关系数震荡收敛到 0。

2.3.3.2 偏自相关函数 (PACF)

你可能发现了,在刚刚的推导中,尽管 \(y_{t-2}\) 没有直接出现在 AR (1) 模型中,但是 \(y_{t-2}\) 也是与 \(y_t\) 相关的。根据我们的推导, \(y_t\) 和 \(y_{t-2}\) 的自相关系数 \(\rho_2\) 等于 \(y_t\) 和 \(y_{t-1}\) 的自相关系数 \(\rho_1\) 乘以 \(y_{t-1}\) 和 \(y_{t-2}\) 的自相关系数(仍为 \(\rho_1\)),所以 \(\rho_2=(\rho_1)^2\)。这并不是偶然,事实上,这样的间接相关出现在任何自回归过程的 ACF 中。

在定阶问题中,这样的间接相关非常重要。比如,我们考虑一个简单的定阶问题,我们意图在 AR(1) 模型和 AR (2) 模型中选一个来分析我们的时间序列。换言之,我们在纠结的是,要不要在我们的模型中加入 \(y_{t-2}\) 这个滞后项。这时, \(y_{t-2}\) 的估计系数可以被视为在 AR(1) 模型上添加 \(y_{t-2}\) 对的 \(y_t\) 的贡献,因此是我们做出决策的一个重要参考。

自然地,我们会问: \(y_{t-2}\) 的估计系数是 \(y_t\) 和 \(y_{t-2}\) 的自相关系数 \(\rho_2\) 吗?答案是否定的。因为我们没有剔除 \(y_{t-1}\) 的影响。就类似于我们在多元线性回归模型中加入控制变量的思想一样,我们想要得到的是 “在控制 \(y_{t-1}\) 保持不变的情况下, \(y_t\) 和 \(y_{t-2}\) 的自相关系数”。这就是 偏自相关系数 。对应的,偏自相关系数 \(\phi\) 和滞后期 \(l\) 的对应关系就是 偏自相关函数 (PACF) 。

下面,我们给出偏自相关函数的正式定义:

[!NOTE] 偏自相关函数(PACF)的定义 偏自相关函数(Partial Autocorrelation Function,PACF)用于度量时间序列中当前值 \(Y_t\) 与滞后 \(k\) 期的值 \(Y_{t-k}\) 之间的纯粹相关性,排除了介于两者之间的所有中间滞后项(\(Y_{t-1}, Y_{t-2}, \ldots, Y_{t-k+1}\))的干扰。

偏自相关函数和自相关函数的关系: 偏自相关函数和自相关函数的关系就类似于偏导数和全导数的关系。 偏自相关函数是在排除了其他变量的影响之后,两个变量之间的自相关函数。

[!Tip] 类比: 偏导数 在数学中,一个多变量的函数的偏导数,就是 它关于其中一个变量的导数而保持其他变量恒定(相对于全导数,在其中所有变量都允许变化)。

现在,我们已经认识了偏自相关函数。那么,请思考:在 AR (1) 过程中,\(y_t\) 和 \(y_{t-2}\) 间的偏自相关系数是多少? 答案是:偏自相关系数为 0。怎么得到的?这就涉及了 偏自相关系数的求解 。

求偏自相关系数最直接的方法如下:

- 首先,对每一观察值减去序列的均值 \(\mu\),得到 \(y_i^* =y_i-\mu\),形成新的序列 \({y_i^*}\),

- 接着,构造 1 阶自回归方程

\[ y_{i}^{*}=\phi_{11}y_{i-1}^{*}+e_{i} \]

式中,\(e_i\) 为误差项。这里之所以采用符号 \({ e_i }\),是因为误差项 \(e_i\) 不一定是白噪声过程(因为 \(e_i\) 含有均值 \(\mu\))。因为没有插入值,则 \(\phi_{11}\) 就同时为 \(y_t\) 和 \(y_{t-1}\) 的自相关和偏自相关系数。

- 现在构造 2 阶自回归方程:

\[ y_t^* = \phi_{21}y_{t-1}^* + \phi_{22}y_{t-2}^* + e_t \]

式中,\(\phi_{22}\) 是 \(y_t\) 和 \(y_{t-2}\) 的偏自相关系数。换言之,\(\phi_{22}\) 是 \(y_t\) 与 \(y_{t-2}\) 的剔除 \(y_{t-1}\) 干扰影响后的相关系数。

- 对其他的所有滞后期 \(s\),可重复这个过程,进而生成偏自相关函数(PACF)。实践中,如果样本容量为 \(T\),那么仅有 \(\dfrac{T}{4}\) 的滞后项可以用来计算样本 PACF。

2.3.3.3 常见模型的 ACF 与 PACF

在前面两节中,我们已经借助 AR (1) 模型认识了自相关函数 ACF 与偏自相关函数 PACF。我们也得到,AR(1) 模型的 ACF 是 \(\rho_0 = 1, \quad \rho_1 = a_1, \quad \rho_2 = a_1^2, \quad \cdots, \quad \rho_l = a_1^l\)、PACF 是 0。 现在,我们来看看其他常用模型的自相关函数 ACF 与偏自相关函数 PACF。

【AR(2) 模型的自相关函数】 我们从更复杂的 AR (2) 过程开始。AR (2) 过程的模型是:\[y_t = a_1 y_{t-1} + a_2 y_{t-2} + \varepsilon_t\] 由于截距项 \(a_0\) 对 ACF 没有影响,所以在此省略。

要使 AR (2) 过程平稳,必须限制特征多项式 \(1 - a_1 L - a_2 L^2\) 的根在单位圆外。接下来,我们 使用 Yule-Walker 方程来推导自协方差、自相关系数 。

- 协方差函数

\[ \gamma_l = Cov(y_t, y_{t-l})= a_1 Cov(y_{t-1}, y_{t-l}) + a_2 Cov(y_{t-2}, y_{t-l}) + Cov(\varepsilon_t,y_{t-l}) \]

- 由于 \(\varepsilon_t\) 与过去的 \(y_{t-1}, y_{t-2}\) 独立,即当 \(l>0\), \(E(\varepsilon_t y_{t-l}) = 0\)。当 \(l=0\),有

\[ Cov(\varepsilon_t,y_t) = a_1 Cov(\varepsilon_t,y_{t-1}) + a_2 Cov(\varepsilon_t,y_{t-2})+Var(\varepsilon_t) = 0+0+\sigma^2=\sigma^2 \]

因此,\(l=0\) 是特殊的,此时 \(\gamma_0 = Var (y_t)\) ,包含 \(\sigma^2\) 项;其他情况不包含 \(\sigma^2\) 项。 3. 我们先考虑 \(l=0\) 的特殊情况:代入 \(l=0\),

\[ \gamma_0 = Var (y_t) =a_1 Cov(y_{t-1},y_t)+ a_2 Cov(y_{t-2},y_t)+\sigma^2 \]

由平稳性,无论时间点 \(t\) ,间隔为 \(l\) 的自协方差均为 \(\gamma_l\)。因此,上式可以表示成:

\[ \gamma_0 = a_1 \gamma_1+ a_2 \gamma_2 +\sigma^2 \]

对应地,自相关系数 \(\rho_0=\dfrac{\gamma_0}{\gamma_0}=1\) 4. 然后我们考虑 \(l=1\) 的情况,代入协方差函数:

\[ \gamma_1 = Cov (y_t, y_{t-1})= a_1 Cov (y_{t-1}, y_{t-1}) + a_2 Cov (y_{t-2}, y_{t-1}) + Cov (\varepsilon_t, y_{t-1}) \]

- 由于 $\varepsilon_t$ 与过去的 $y_{t-1}, y_{t-2}$ 独立,有 $Cov (\varepsilon_t, y_{t-1}) = 0$;

- $Cov (y_{t-1}, y_{t-1})=Var (y_{t-1})=\gamma_0$;

- 由平稳性,无论时间点 $t$ ,间隔为 $l$ 的自协方差均为 $\gamma_l$。因此 $Cov (y_{t-2}, y_{t-1})=\gamma_1$。

- 因此:<font color="#245bdb"> 自协方差 </font> $\gamma_1=a_1 \gamma_0 +a_2 \gamma_1$ ,解出 $\gamma_1=\dfrac{a_1}{1-a_2}\gamma_0$ 。

- <font color="#245bdb"> 自相关系数 </font> $\rho_1=\dfrac{\gamma_1}{\gamma_0}=\dfrac{a_1}{1-a_2}$- 请自行完成 \(l=2\) 情况的推导。我们最终得到,\(\rho_2=\dfrac{\gamma_2}{\gamma_0}=\dfrac{a_1^2}{1-a_2}+a_2\)

- 【一般化】:由平稳性,无论时间点 \(t\) ,间隔为 \(l\) 的自协方差均为 \(\gamma_l\)。我们现在考虑一般化的协方差函数:

1 | |

由此,得到自协方差:\(\gamma_l=a_1 \gamma_{l-1} +a_2 \gamma_{l-2}\),自相关系数:\(\rho_l=\dfrac{\gamma_l}{\gamma_0}=a_1 \rho_{l-1}+a_2 \rho_{l-2}\)。

【AR (2) 模型的偏自相关函数】

- 对 AR (2) 模型,序列依赖仅存在于 \(y_{t-1}\) 和 \(y_{t-2}\),当分析 \(k > 2\) 的滞后项时,\(y_t\) 与 \(y_{t-k}\) 的直接相关性被模型结构截断,因此 \(\phi_{k, k} = 0\)。

- 而 \(k=2\) 时,模型中直接包含 \(y_{t-2}\) 的系数 \(a_2\),即 \(\phi_{2,2} = a_2\)。

- 由 \(\rho_1=\dfrac{\gamma_1}{\gamma_0}=\dfrac{a_1}{1-a_2}\),得到 \(a_1=\rho_1 (1-a_2)\);代入 \(\rho_2=\dfrac{\gamma_2}{\gamma_0}=\dfrac{a_1^2}{1-a_2}+a_2\),得到 \(\rho_2 =\rho_1^2-a_2\rho_1^2+a_2\),从而 \(\phi_{2,2} = a_2=\dfrac{\rho_2 - \rho_1^2}{1 - \rho_1^2}\)。

对应地,AR (2) 自相关函数如左图,偏自相关函数如右图。

【进一步推广:AR (p) 模型】

[!Note] 思考:AR (p)模型的自相关函数 ACF 与偏自相关函数 PACF ?

\[ \begin{split} y_t &= a_0 + a_1 y_{t-1} + a_2 y_{t-2} + \cdots + a_p y_{t-p} + \varepsilon_t \\ &= a_0 + \sum_{i = 1}^{p} a_i y_{t-i} + \varepsilon_t \notag \end{split} \]

[!Tip] 【补充】Yule-Walker 方程的定义 所以,到底什么是 Yule-Walker 方程?Yule-Walker 方程是 AR 模型的正则方程。

定理 (Yule-Walker 方程) AR(p) 序列的自协方差函数满足

\[ \begin{align*} \gamma_k &= a_1 \gamma_{k-1} + a_2 \gamma_{k-2} + \cdots + a_p \gamma_{k-p},\quad \ k \geq 1 \\ \gamma_0 &= a_1 \gamma_1 + a_2 \gamma_2 + \cdots + a_p \gamma_p + \sigma^2 \end{align*} \]

Yule-Walker 方程系统地刻画了 AR (p) 模型中 p 阶范围内 自相关系数之间的关系,以及自相关系数与模型结构的关系。

对于 AR(p) 模型,偏自相关系数满足 \(\phi_{11} = \rho_1\),\(\phi_{22} = \dfrac{\rho_2 - \rho_1^2}{1 - \rho_1^2}\),向后递推:

\[ \phi_{ss} = \frac{\rho_{s} - \sum_{j = 1}^{s-1} \phi_{s-1, j}\rho_{s-j}}{1 - \sum_{j = 1}^{s-1} \phi_{s-1, j}\rho_{j}} \quad s = 3,4,5,\cdots \]

式中,\(\phi_{sj} = \phi_{s-1,j} - \phi_{ss}\phi_{s-1,s-j}, j = 1, 2, 3, \cdots, s-1\)。

对于 AR (p) 过程,当 s > p 时,\(y_t\) 和 \(y_{t-s}\) 之间不存在直接相关。因此,当 s > p 时,所有 \(\phi_{ss}\) 都等于 0。这表明: 对于 AR (p) 过程,它的 PACF 在滞后期大于 p 时,均应该截尾为 0 。这是 PACF 一个重要的特征,它可用于辅助识别 AR (p) 模型。 **

【MA 模型】

- MA(1)模型的 ACF:

- 依旧省略常数项,MA (1)模型为:\(y_{t} = \varepsilon_{t} + \beta \varepsilon_{t-1}\)

- 由于 \(y_{t}\)

是由白噪声序列中的项组成,所以不需平稳条件就可求得 \(\rho\) 的形式如下:

- \(\rho_{0} = 1\)

- \(\rho_{1} = \beta / (1 + \beta^{2})\)

- \(\rho_{s} = 0, (s > 1)\)

- 因此,MA(1) 的 ACF 是 1 步截尾。

[!Note] 思考:如何推导? \(\gamma_0=Cov(y_t,y_t)=Var(\varepsilon_{t} + \beta \varepsilon_{t-1})=(1+\beta^2)\cdot \sigma^2\) \(\quad \Rightarrow \quad \rho_0=\dfrac{\gamma_0}{\gamma_0}=1\)

\(\gamma_1=Cov(y_t,y_{t-1})=Cov(\varepsilon_{t} + \beta \varepsilon_{t-1},\varepsilon_{t-1} + \beta \varepsilon_{t-2})= 0+\beta \sigma^2+0+0=\beta \sigma^2\)

\(\quad \Rightarrow \quad \rho_1=\dfrac{\gamma_1}{\gamma_0}=\dfrac{\beta \sigma^2}{(1+\beta^2)\cdot \sigma^2}=\dfrac{\beta }{1 + \beta^{2}}\)

当 s > 1, \(\gamma_s=Cov(y_t,y_{t-s})=Cov(\varepsilon_{t} + \beta \varepsilon_{t-1},\varepsilon_{t-s} + \beta \varepsilon_{t-1-s})= 0+0+0+0=0\)

MA(2)模型的 ACF: 请回顾 2.1.2.2 MA(q) 的平稳性(#2.1.2.2%20MA(q)%20 的平稳性) 对 MA(2) 自协方差的推导,讨论在不同滞后期下的 \(\rho\) 分布。我们可以发现,MA (2) 的 ACF 是 2 步截尾。

MA(q)模型的 ACF: MA (q) 模型为: \[x_t = \beta_0 \varepsilon_t + \beta_1 \varepsilon_{t-1} + \cdots +\beta_q \varepsilon_{t-q} = \sum_{i = 0}^{q} \beta_i \varepsilon_{t-i} \notag\] 同样地,我们也可以讨论在不同滞后期下的 \(\rho\) 分布。我们可以从 MA(1) 和 MA(2) 过程外推得到:对于 MA (q) 模型, \(\rho_{q+1}\) 开始之后都为 0。即: q 阶之后突然截断变为 0 。

MA (q) 模型的 PACF: 使用滞后算子,结合级数展开,只要 \(\beta \neq -1\),MA(1)模型可以写为:

\[ y_t= (1 + \beta L) \varepsilon_t \]

- 可以把 $\varepsilon_t$ 表述为无限阶自回归表达式 $y_t - \beta y_{t-1} + \beta^2 y_{t-2} - \beta^3 y_{t-3} + \cdots = \varepsilon_t$。

- 由于 $y_t$ 同自身的所有滞后项相关,所以, **MA (q) 模型的 PACF 不会截尾到 0**。

- 相反,**PACF 系数表现出衰减形式(即具有拖尾特征)**。若 $\beta < 0$,PACF 的系数直接衰减;若 $\beta > 0$,PACF 的系数振荡衰减。【ARMA 模型的 ACF 推导】 在得到 AR(p) 、MA(q) 模型的 ACF、PACF 后,我们现在来讨论 ARMA(p, q) 的 ACF 和 PACF。我们还是从特例 ARMA(1,1) 过程开始。ARMA(1,1) 模型为:

\[ y_t = a_1 y_{t-1} + \varepsilon_t + \beta_1 \varepsilon_{t-1}, \quad \varepsilon_t \sim WN(0, \sigma^2) \]

- 无需计算 \(\gamma_0\),就有自相关系数 \(\rho_0=\dfrac{\gamma_0}{\gamma_0}=1\)。我们还可以推导 \(\gamma_0\) 和 \(\gamma_1\) 关系:

\[ \begin{split} \gamma_0 &= Var(y_t) = Cov(y_t, a_1 y_{t-1} + \varepsilon_t + \beta_1 \varepsilon_{t-1}) \\ &= a_1 Cov(y_t, y_{t-1})+Cov(y_t,\varepsilon_t)+\beta_1 Cov(y_t,\varepsilon_{t-1}) \\ &= a_1 \gamma_1 +Cov(a_1 y_{t-1} + \varepsilon_t + \beta_1 \varepsilon_{t-1},\varepsilon_t)+\beta_1 Cov(a_1 y_{t-1} + \varepsilon_t + \beta_1 \varepsilon_{t-1},\varepsilon_{t-1}) \\ &= a_1 \gamma_1 +(0+ \sigma^2 +0)+\beta_1 [a_1 Cov(a_1 y_{t-2} + \varepsilon_{t-1} + \beta_1 \varepsilon_{t-2},\varepsilon_{t-1})+0+\beta_1\sigma^2] \\ &= a_1 \gamma_1 +\sigma^2+ a_1\beta_1\cdot(0+\sigma^2+0)+\beta_1^2\sigma^2 \\ &= a_1 \gamma_1 +(1+a_1\beta_1+\beta_1^2)\sigma^2 \end{split} \]

如果想求得 \(\gamma_0\),可以把下面 \(\gamma_1\) 代入,解出 \(\gamma_0 =\dfrac{1+2a_1\beta_1+\beta_1^2}{1-a_1^2}\sigma^2\)。 2. 计算 \(\gamma_1\):

\[ \begin{align*} \gamma_1 &= Cov(y_t, y_{t-1}) = Cov(a_1 y_{t-1} + \varepsilon_t + \beta_1 \varepsilon_{t-1}, y_{t-1})\\ &= a_1 Var(y_{t-1}) + Cov(\varepsilon_t, y_{t-1})+ \beta_1 Cov(\varepsilon_{t-1}, y_{t-1}) \\ &= a_1 \gamma_0 + 0+ \beta_1 Cov(a_1 y_{t-2} + \varepsilon_{t-1} + \beta_1 \varepsilon_{t-2},\varepsilon_{t-1}) \\ &= a_1 \gamma_0 + \beta_1 \sigma^2 \end{align*} \]

这时,\(\rho_1 =\dfrac{\gamma_1}{\gamma_0}= a_1+\dfrac{\beta_1 \sigma^2}{\gamma_0}\)。 3. 计算 \(\gamma_2\):

\[ \begin{align*} \gamma_2 &= Cov(y_t, y_{t-2}) = Cov(a_1 y_{t-1} + \varepsilon_t + \beta_1 \varepsilon_{t-1}, y_{t-2})\\ &= a_1 Cov(y_{t-1}, y_{t-2}) + Cov(\varepsilon_t, y_{t-2})+ \beta_1 Cov(\varepsilon_{t-1}, y_{t-2}) \\ &= a_1 \gamma_1 \end{align*} \]

这时,\(\rho_2 =\dfrac{\gamma_2}{\gamma_0}= a_1 \rho_1\)。 4. 考虑 \(\gamma_k\) (\(k>1\))的情况:

\[ \begin{align*} gamma_k &= Cov(y_t, y_{t-k}) = Cov(a_1 y_{t-1} + \varepsilon_t + \beta_1 \varepsilon_{t-1}, y_{t-k})\\ &= a_1 Cov(y_{t-1}, y_{t-k}) + Cov(\varepsilon_t, y_{t-k})+ \beta_1 Cov(\varepsilon_{t-1}, y_{t-k}) \\ &= a_1 \gamma_{k-1} \end{align*} \]

这时,\(\rho_k =\dfrac{\gamma_k}{\gamma_0}= a_1 \rho_{k-1}\),呈现指数衰减(拖尾)。 这个式子也表明 \(k=0\) 和 \(k=1\) 的特殊性:

- 当 \(k=0\),\(Cov (\varepsilon_t, y_{t-k})\) 和 \(Cov (\varepsilon_{t-1}, y_{t-k})\) 均不为 0;

- 当 \(k=1\),\(Cov (\varepsilon_t, y_{t-k})\) 为 0,但 \(Cov (\varepsilon_{t-1}, y_{t-k})\) 不为 0;

- 只有在 \(k>1\) 时,二者均为 0。

[!Excercise] 练习:请推导 ARMA(2,1) 、ARMA (1,2)的 ACF,并推广至 ARMA(p, q) 的情形。 ARMA(2,1) 的 ACF 满足:

- 计算 \(\gamma_0\):\(\gamma_0 = a_1 \gamma_1 + a_2 \gamma_2 + \sigma^2 (1+a_1\beta_1 + \beta_1^2)\),\(\rho_0=1\)

- 计算 \(\gamma_1\):\(\gamma_1 = a_1 \gamma_0 + a_2 \gamma_1 + \beta_1 \sigma^2\),\(\rho_1 = \dfrac{\gamma_1}{\gamma_0}=\dfrac{a_1}{1 - a_2}\rho_0+\dfrac{\beta_1 \sigma^2}{(1 - a_2)\gamma_0}\)

- 计算 \(\gamma_2\):\(\gamma_2 = a_1 \gamma_1 + a_2 \gamma_0\),\(\rho_2 =\dfrac{\gamma_2}{\gamma_0}= a_1 \rho_1 + a_2\)

- 高阶递推:当 \(k>1\) 时,\(\rho_k = a_1 \rho_{k-1} + a_2 \rho_{k-2}\)

ARMA (1,2) 的 ACF 满足:

- 计算 \(\gamma_0\): \(\gamma_0 = a_1 \gamma_1 + \sigma^2(1 + \beta_1^2 + \beta_2^2 + 2a_1\beta_1 + 2a_1\beta_2)\),\(\rho_0 = 1\)。

- 计算 \(\gamma_1\): \(\gamma_1 = a_1 \gamma_0 + \sigma^2(\beta_1 + \beta_2a_1)\), \(\rho_1 = \dfrac{\gamma_1}{\gamma_0} = a_1 + \dfrac{\sigma^2(\beta_1 + \beta_2 a_1)}{\gamma_0}\)。

- 计算 \(\gamma_2\): \(\gamma_2 = a_1 \gamma_1 + \sigma^2\beta_2\), \(\rho_2 = \dfrac{\gamma_2}{\gamma_0} = a_1 \rho_1 + \dfrac{\sigma^2\beta_2}{\gamma_0}\)。

- 计算 \(\gamma_3\): \(\gamma_3 = a_1 \gamma_2\), \(\rho_3 = \dfrac{\gamma_3}{\gamma_0} = a_1 \rho_2\)。

- 高阶递推: 当 \(k>2\) 时,\(\rho_k = a_1 \rho_{k-1}\)。

对比于 ARMA (1,1),有什么发现?推广到 ARMA (p, q) 的 ACF 呢?

- ARMA(p, q) 中,p 增加,递推公式的项数增加;q 增加则不符合递推的项数增加。

- 递推从 q+1 项开始,递推的公式是 \(\rho_k=a_1 \rho_{k-1}+a_2 \rho_{k-2}+\cdots+a_p \rho_{k-p}\)(递推公式的项数为当期向前推 p 项)。

- 因此,ARMA(p, q) 的高阶递推可以表示为:当 \(k>q\) 时,\(\rho_k =\sum_{i=1}^p a_i \rho_{k-i}\)。

- 由于我们考虑的是平稳的时间序列,特征根在单位圆内。因此自相关系数在递推中不断衰减, 呈现拖尾特征 。

【ARMA (p, q) 模型的 PACF 推导】 偏自相关系数(PACF)的本质是条件协方差,无截尾性,呈拖尾特征。我们还是从 ARMA (1, 1)情况开始分析。ARMA (1,1) 模型为:

\[ y_t = a_1 y_{t-1} + \varepsilon_t + \beta_1 \varepsilon_{t-1}, \quad \varepsilon_t \sim WN(0, \sigma^2) \]

当 \(k = 1\) 时,在前面 ACF 的推导中,我们已经得到:\(\gamma_1=a_1 \gamma_0 + \beta_1 \sigma^2\)。

\[ \phi_{11}=\dfrac{\gamma_1}{\gamma_0}=\dfrac{a_1 \gamma_0+\beta_1 \sigma^2}{\gamma_0}=a_1+\dfrac{\beta_1\sigma^2}{\gamma_0} \]

事实上,我们发现,ARMA (1,1) 模型的 PACF 等于 ACF,即 \(\phi_{11} = \rho_1\) 。

接着,我们考虑 \(k = 2\) 的情况。在前面 ACF 的推导中,我们已经得到:\(\gamma_2=a_1 \gamma_1\)。我们可以进一步结合 \(\gamma_1=a_1 \gamma_0 + \beta_1 \sigma^2\),得到:\(\gamma_2=a_1^2 \gamma_0 + a_1 \beta_1 \sigma^2\)。此外,还有 \(\gamma_0=\frac{1+2a_1\beta_1+\beta_1^2}{1-a_1^2}\sigma^2\) 。根据偏自相关函数与自协方差函数的关系,有:

\[ \gamma_2=Cov(y_t,y_{t-2})=Cov(\phi_{21}y_{t-1}+\phi_{22}y_{t-2}+\varepsilon_t,y_{t-2})=\phi_{21}\gamma_1+\phi_{22}\gamma_0 \]

结合 \(k=1\) 的情况:

\[ \begin{cases}\gamma_1 =\phi_{11}\gamma_0\\\gamma_2 =\phi_{21}\gamma_1+\phi_{22}\gamma_0\end{cases} \quad \Rightarrow \quad \gamma_2 =(\phi_{21}\phi_{11}+\phi_{22}) \gamma_0 \]

我们希望得到的目标是 \(\phi_{22}\),上面已经求解过了 \(\phi_{11}\),我们现在就考虑消去 \(\phi_{21}\)。但是我们看到 \(\phi_{21}\) 和 \(\phi_{22}\) 两个参数只有一个方程,因此需要再找到一个方程以求解。我们考虑:

\[ \gamma_1 = Cov(y_t, y_{t-1})= Cov(\phi_{21}y_{t-1}+\phi_{22}y_{t-2}+\varepsilon_t, y_{t-1})=\phi_{21}\gamma_0+\phi_{22}\gamma_1 \]

因此,我们得到:\(\phi_{21} = \dfrac{\gamma_1 (1 - \phi_{22})}{\gamma_0}=\dfrac{\gamma_1}{\gamma_0}-\dfrac{\gamma_1}{\gamma_0}\phi_{22}=\rho_{1}-\rho_{1}\phi_{22}\),从而:

\[ \dfrac{\gamma_2}{\gamma_0}=\rho_2 =\phi_{21}\phi_{11}+\phi_{22}=(\rho_1 - \rho_1 \phi_{22})\phi_{11}+\phi_{22}=\phi_{11}\rho_1+(1-\phi_{11}\rho_1)\phi_{22} \]

因此得到 \(\phi_{22}=\dfrac{\rho_2-\phi_{11}\rho_1}{1-\phi_{11}\rho_1}\)。又有 \(\phi_{11}=\rho_1\),得到 \(\phi_{22}=\dfrac{\rho_2-\rho_1^2}{1-\rho_1^2}\)。

ARMA (1,1) 模型 PACF 的推导可以借助 Levinson 递推公式:

\[ \begin{cases} \phi_{11} = \rho_1, \\ \\ \phi_{ss} = \dfrac{\rho_s - \sum_{j = 1}^{s-1} \phi_{s-1, j} \ \rho_{s-j}}{1 - \sum_{j = 1}^{s-1} \phi_{s-1, j} \ \rho_j}, \quad s \geq 2, \\ \\ \phi_{sj} = \phi_{s-1, j} - \phi_{ss} \phi_{s-1, s-j}, \quad j = 1,2,\dots, s-1.\end{cases} \]

对 \(s \geq 2\),可以将已求得的 ACF(\(\rho_k\)) 代入递推公式计算。 因 ARMA (p, q) 包含 MA 部分,PACF 不满足截尾,而是随阶数增加逐渐衰减(拖尾),具体数值需逐阶递推。

可以看出,使用 PACF 为 ARMA(p, q) 模型定阶是非常困难的。有什么好办法吗? 【补充】ARMA(p, q)模型阶数方法 1: EACF 函数 。

- 使用方法:将 ACF 汇总于表格中。用“o”表示零,“x”表示非零。“o”形成的三角形的左上角的点对应的 p 和 q 就是模型应对的 p 和 q。

- 例子:左上角的“o”点坐标为(1,1),故为 ARMA(1,1)。

1 | |

EACF 函数方法是 ARMA 模型基于 ACF 、PACF 的定阶方法。另一种方法是使用信息准则,设定 \(P_{max}\) 和 \(Q_{max}\) 后逐个回归,通过信息准则筛选最小信息准则的阶数。下面我们就来介绍两种主流的信息准则。

2.3.3.4 信息准则

对估计出的模型,人们自然会问:模型对数据的拟合程度如何? 增加额外的滞后期必然会使估计残差的平方和减小。然而,增加这些滞后项必然要求估计额外的系数,相应地减少了自由度。 甚至,包含了无关紧要的系数还会降低拟合模型的预测效果。

当今的多种模型筛选准则都倾向于以放弃减少残差平方和为代价,而选择一个更加简练的模型。最常使用的模型筛选准则是 赤池信息准则 (Akaike Information Criterion, AIC ) 和施瓦茨准则 (Schwartz Bayesian Criterion, SBC ,也常被称为 BIC)。在课本中计算式为:

\[ \begin{split} AIC &= T \ln S+2 n \\ \\ SBC &= T \ln S+n \ln (T) \end{split} \]

- 其中 \(n\) 为待估参数个数(p+q+或有的常数项);\(T\) 为可用观测值个数;S 为残差平方和。

- 或者,更经常地,我们把它们表示为标准化的:

\[ \begin{split} AIC^* &=\frac{AIC}{T}= –2 \frac{\ln (L)}{T} + 2 \frac{n}{T} \\ \\ SBC^* &=\frac{SBC}{T}= –2 \frac{\ln (L)}{T} + \frac{n \ln (T)}{T} \end{split} \]

其中, n 和 T 如上所述定义,L 是似然函数。

- 在教材中给出的 \(T\ln S\) 和常用的 \(-2\ln(L)\) 是近似的,对于模型比选没有差异。这涉及了对数似然函数的最大值,我们将在 2.3.4 参数的估计策略 更详细地讨论极大似然估计,并证明两种表示方法为什么对于模型比选没有差异。

[!tip] 惩罚 在统计学和机器学习中,惩罚 是一种通过引入额外项来约束模型复杂度的策略。

- 信息准则是通过对拟合优度的要求加上对参数个数的惩罚指定一个准则来定阶的。

- 惩罚项的作用是:当模型参数过多时,虽然似然函数 L 可能增大(拟合更好),但惩罚项 2n 会显著增加,导致 AIC 整体上升。 这迫使模型在 “过度拟合数据” 和 “保持简洁性” 之间寻找最优解 。

注意:

- 当用滞后变量估计模型时,会损失部分观测值。为了充分比较备选模型,T 应保持不变,否则,我们将依据不同的样本期来比较模型的效果。 T 的减少会直接降低 AIC 和 SBC 的效果,而我们的目的显然不是选择一个可用观测值最少的模型。例如,有 100 个数据点时,只用后 98 个观测值分别估计 AR (1) 和 AR (2) 模型,再用 T = 98 比较两个模型的效果。

- 理论上,AIC 和 SBC 要尽可能地小 (注意,二者皆可为负)。当模型的拟合优度上升时,AIC 和 SBC 的值会趋于负无穷。 我们可以用这些准则来辅助选出最合适的模型。若模型 A 的 AIC (或 SBC) 小于模型 B,则称模型 A 优于模型 B。在运用准则比较各种备选模型时,我们必须基于相同的样本期来估计,这样二者才可以比较。

- 对于每个模型,解释变量的增加会导致 n 的增加,但残差平方和 (SSR) 会减少。因此,若某个解释变量对模型没有解释力,则在模型中引入它只会导致 AIC、SBC 同时变大。

[!Note] SBC 与 AIC 的比较:

SBC 总是比 AIC 选择出的模型更简练 。这时因为, \(\ln(T)\) 大于 2,所以,SBC 增加解释变量的边际成本总是比 AIC 大。

SBC 具有更优的大样本特性。 假定数据生成过程的真实阶数为 \((p^*,q^*)\),并且假设用 AIC 和 SBC 估计所有阶数为 \((p, q)\) 的 ARMA 模型,其中 \(p≥p^*\),\(q>q^*\)。当样本容量趋于无限时,AIC 和 SBC 选出的模型的阶数都会大于等于 \((p^*,q^*)\)。但是,SBC 趋向于一致,而 AIC 则倾向于选择参数过多的模型 。 在小样本下,AIC 选择模型的效果要优于 SBC 。

- 如果 AIC 和 SBC 都选择了相同的模型,那么,我们有理由相信这个模型是个恰当的模型。

- 但是,若 AIC 和 SBC

筛选出的模型不同,那么,为了谨慎起见,我们仍然要继续研究。

- 因为 SBC 选出的模型更加简练,所以,应该检验 残差是否表现为白噪声过程(以证明模型确实对数据有解释力度)。

- 因为 AIC 选择的模型含有过多的参数,那么,所有系数的 \(t\) 统计量应该显著(以证明这些参数的加入是必要的)。

2.3.4 Box-Jenkins 模型筛选:估计

在大多数情况下,我们通过回归方法分析时间序列。回归对样本有独立性假设,时间序列分析 利用数据相关性(惯性) 分析预测,二者在某些方面有一定的相似。因此,我们有时候 使用最小二乘方法来估计时间序列的参数。比如我们之前 1.5 自回归(AR)模型 学到的自回归 AR 模型,以及 2.1.2 移动平均模型(MA) 学习的移动平均 MA 模型。在 2.3.3.2 偏自相关函数 (PACF) 讨论定阶时,我们对于 “是否加入 \(y_{t-2}\) 滞后项” 的讨论就是基于多元线性回归框架的,因此使用的是最小二乘估计。

当然,在最小二乘估计之外,还有很多其他估计方法。比如矩估计 (MME),极大似然估计 (MLE),条件最小二乘 (CLS)等。在 2.3.3.1 自相关函数(ACF) 中我们用到的 Yule-Walker 估计一种对参数的矩估计。最小二乘估计与 Yule-Walker 估计渐近相同,在样本量较小时,Yule-Walker 方法在估计系数方面表现较好,最小二乘估计方法在预测方差方面表现较好。样本量大时二者没有明显差别。相较于其他估计方法,矩估计更容易计算,但这也使得矩估计存在精度不高的可能性。而最大似然估计一般精度较高。相较于 OLS 估计,我们对似然估计相对陌生。因此,本节以 AR (p) 模型为例,重点介绍似然函数(MLE)的计算。

- 我们假设似然函数是联合正态分布密度函数,给定 AR(p)模型:

\[ r_t = \phi_0 + \phi_1r_{t - 1} + \cdots + \phi_pr_{t - p} + a_t, \quad t = p + 1,\cdots, T \]

将联合似然函数表示为条件似然的乘积,似然函数为

\[ \begin{align *} L &= f(r_1, r_2,\cdots, r_T)\\ &= f(r_1)f(r_2|r_1)f(r_3|r_1, r_2)\cdots f(r_T|r_1,\cdots, r_{T - 1}) \end{align*} \]

- 当 \(t \geq 2\) 时,则可以计算 \(r_t\) 的条件分布。由于

\[ r_2|r_1 = \phi_0 + \phi_1r_1 + a_2 \sim N(\mu_2,\sigma_a^2) \]

其中:\(\mu_2 = \phi_0 + \phi_1r_1\)。因此正态分布的概率密度函数为:

\[ f(r_2|r_1) = \frac{1}{\sqrt{2\pi}\sigma_a}\exp\left\{ - \frac{(r_2 - \mu_2)^2}{2\sigma_a^2} \right\} \]

同理

\[ r_3|r_1, r_2 = \phi_0 + \phi_1r_2 + \phi_2r_1 + a_3 \sim N(\mu_3,\sigma_a^2) \]

其中:\(\mu_3 = \phi_0 + \phi_1r_2 + \phi_2r_1\)。因此

\[ f(r_3|r_1, r_2) = \frac{1}{\sqrt{2\pi}\sigma_a}\exp\left\{ - \frac{(r_3 - \mu_3)^2}{2\sigma_a^2} \right\} \]

依此类推。因此,

\[ L = f(r_1) \frac{1}{(2\pi)^{\frac{T - 1}{2}}\sigma_a^{T - 1}}\exp\left\{ - \frac{1}{2\sigma_a^2} \sum_{t = 2}^T(r_t - \mu_t)^2 \right\} \]

注:同底数幂相乘,底数不变指数相加因而出现求和;以及不要遗漏 \(f(r_1)\)。 3. 取对数,得到对数似然函数:

\[ \ln{L} = \ln f(r_1) - \frac{T - 1}{2} \left [\ln(2\pi)+2\ln\sigma_a\right] - \frac{1}{2\sigma_a^2} \sum_{t = 2}^T(r_t - \mu_t)^2 \]

得到似然函数后就可以通过最大化对数似然函数估计模型参数。

[!NOTE] (填坑)不同 AIC、SBC 表示的比较 现在,我们可以返回来考虑 2.3.3.4 信息准则 中那个比较了。这也可以作为极大似然估计的一个练习。

对于时间序列 \(\{r_t\}\),有极大似然估计 \[\ln{L} = \ln f(r_1) - \dfrac{T - 1}{2} \left[\ln(2\pi)+2\ln\sigma\right] - \dfrac{1}{2\sigma^2} \sum_{t = 2}^T(r_t - \mu_t)^2\] 我们需要最大化似然函数 \(\ln L\) 。但为了计算方便,我们不立刻这样处理,而是先根据正态分布的性质化简一下。

对于正态分布,概率密度函数(PDF)为

\[ f (x)=\dfrac{1}{\sqrt{2\pi\sigma^{2}}}\exp\left (-\dfrac{(x - \mu)^{2}}{2\sigma^{2}}\right) \]

那么,

\[ \ln(f(x))=\ln(\dfrac{1}{\sqrt{2\pi\sigma^{2}}})+(-\dfrac{(x - \mu)^{2}}{2\sigma^{2}})=-\frac{1}{2}\ln(2\pi\sigma^2)-\dfrac{(x - \mu)^{2}}{2\sigma^{2}} \]

代入得:

\[ \begin{split} –2 \ln (L) &= -2\ln(f(r_1)) +(T - 1)\left[\ln(2\pi)+2\ln\sigma\right] + \dfrac{1}{\sigma^2} \sum_{t = 2}^T(r_t - \mu_t)^2 \\ &=\ln(2\pi\sigma^2)+\dfrac{(r_1 - \mu)^{2}}{\sigma^2} +(T-1)\ln(2\pi\sigma^2)+\dfrac{1}{\sigma^2} \sum_{t = 2}^T(r_t - \mu_t)^2 \\ &= T\ln (2πσ^2) + \dfrac{(r_1 - \mu)^{2}}{\sigma^2}+\dfrac{1}{\sigma^2} \sum_{t = 2}^T(r_t - \mu_t)^2 \\&= T\ln (2π) +T\ln(σ^2)+\dfrac{1}{\sigma^2} \sum_{t = 1}^T(r_t - \mu_t)^2 \end{split} \]

其中 \(\sum_{t = 1}^T(r_t - \mu_t)^2\) 是残差平方和,为简便我们可以把它记为 S。

现在,我们可以最大化似然函数 \(\ln L\) 了。这与我们在最小二乘估计时的方法类似,我们可以对 \(σ^2\) 求导并令导数为零。我们可以得到:

\[ \frac{\partial}{\partial \sigma^2} \left[ T \ln(2\pi) +T\ln(\sigma^2)+ \dfrac{S}{\sigma^2} \right] = \frac{T}{\sigma^2} - \dfrac{S}{\sigma^4} = 0 \]

进而得到一个美妙的关系式: \(\sigma^2 = \dfrac{S}{T}\) 。因此,我们就可以把原式 \(\sigma^2\) 替换,得到

\[ \begin{split} –2 \ln (L) &= T\ln (2π) + T\ln(σ^2)+\dfrac{1}{\sigma^2} \sum_{t = 1}^T(r_t - \mu_t)^2 \\&=T\ln(2\pi)+T\ln(\dfrac{S}{T})+\dfrac{T}{S}\cdot S\\&=T\ln(2\pi)+T\ln(S)-T\ln(T)+T \end{split} \]

由于 \(T\) 为可用观测值个数,\(T\ln(2\pi)-T\ln(T)+T\) 本质上是常数项。这表明二者在本质上是一致的。由于模型筛选的本质是 相对比较,比较时常数项会相互抵消,最终决策仅依赖核心项(残差平方和 S 、参数数量 n)。因此,是否保留常数项不影响使用。

在极大似然估计之外,我们再介绍一下 条件最小二乘估计(CLS)。条件最小二乘在估计时考虑了模型的条件结构,即在给定过去值的情况下,当前值的预测误差最小化。下面我们介绍其做法:

- 从第 \(p + 1\) 个观测值开始估计。给定前 \(p\) 个观测值,对于 \(t = p + 1,\cdots,T\),我们有:

\[ r_t = \phi_0 + \phi_1r_{t - 1} + \cdots + \phi_pr_{t - p} + a_t \]

设估计结果为:\(\hat{r}_t = \hat{\phi}_0 + \hat{\phi}_1r_{t - 1} + \cdots + \hat{\phi}_pr_{t - p}\)

- 残差序列 \(\{\hat{a}_t\}\) 为:\(\hat{a}_t = r_t - \hat{r}_t\)

- \(\sigma_a\) 的估计值: \[\hat{\sigma}_a^2 = \frac{\sum_{t = p + 1}^T\hat{a}_t^2}{T - 2p - 1}\]

- 自然地,我们会疑惑:“条件”在哪里了?事实上,我们只是考察了 p+1 时刻之后的噪声项,这就是“条件”。

2.3.5 Box-Jenkins 模型筛选:评价

完成 Box-Jenkins 模型筛选方法的识别、估计阶段之后,我们进入 诊断检验阶段 。也就是说,我们要对初步确定的模型进行评价和比较。估计恰当的模型应满足以下条件:

- 简练;

- 其系数表现为平稳且可逆;

- 拟合数据较好;

- 残差接近白噪声过程;

- 系数不随样本期改变而改变;

- 有较好的样本区间外预测。 这些内容分布在课本 2.7-2.13 节,出于知识衔接的考虑,我们先介绍白噪声检验(对应于第 4 条原则),然后介绍可逆性(第 2 条)和简练原则(第 1 条),最后讨论样本区间外预测(第 6 条)、系数不随样本期改变而改变(第 5 条)以及更优拟合效果(第 3 条)的内容。

2.3.5.1 白噪声检验

在诊断检验阶段,确定模型恰当的一个非常重要的条件是:确保估计模型的残差能够模拟白噪声过程。此外,我们也曾在 2.3.3.4 节最后指出:使用施瓦茨信息准则(SBC)应该检验残差是否表现为无分析价值的白噪声过程。那么,如何进行这一检验呢?

Box-Jenkins (1976) 用样本自相关系数构造了 Q 统计量,计算公式为 Box-Pierce 形式:

\[ Q_{BP} = T \sum_{k=1}^s r_k^2 \]

在所有的 r 值等于 0 的原假设下,Q 近似地服从自由度为 s 的卡方分布。

- 用途:检测时间序列是否存在显著的自相关(即当前值与历史值是否相关)。

- 使用这个统计量,明显可以发现较高的样本自相关系数将导致较大的 Q 值。

- 白噪声过程 (在这个过程中,所有自相关系数应该为 0) 的 Q 值为 0。

- 假设检验:

- 原假设(H₀):序列无自相关(即纯随机性/白噪声)。

- 判断标准:若计算出的 Q 统计量超过卡方分布的临界值(或 p 值 < 0.05),则拒绝原假设,认为存在自相关。

- 不足:Box-Pierce 形式的 Q 统计量适用于大样本,但在相对较小的样本中效果不佳。即使是适度大的样本,其效果也较差。

基于此,Ljung-Box(1978)提出了更优、对小样本同样适用的修正 Q 统计量,公式为:

\[ Q_{LB} = \frac{T(T+2) \sum_{k=1}^s r_k^2}{T-k} \]

它与 \(Q_{BP}\) 的差别与关联是:

\[ Q_{LB} = \frac{T(T+2) \sum_{k=1}^s r_k^2}{n-k}=\frac{T+2}{T-k}Q_{BP} \]

其中,\(T\) 为样本量,\(m\) 为最大滞后阶数,\(r_k\) 为 k 阶自相关系数。

Box-Pierce 和 Ljung-Box 的 Q 统计量同样可以用于检验被估的 ARMA (p, q) 模型的残差是否为白噪声过程,然而,若从被估的 ARMA (p, q) 模型中得到了 s 个自相关系数,则自由度会随待估系数的增加而减少。因此,若使用 ARMA (p, q) 模型的残差,Q 统计量服从自由度为 s-p-q 的卡方分布 (若模型包含了一个常数,则自由度为 s-p-q-1)。

2.3.5.2 可逆性

在诊断检验阶段,确定模型恰当的另一个非常重要的条件是平稳可逆。正如我们在 2.3.3 Box-Jenkins 模型筛选:定阶 一开始就提到的,我们在本章仅讨论平稳的时间序列,因此,这一节我们讨论的重点是可逆性(invertible)。我们将围绕三个问题展开本小节:

- 什么是可逆性?

- 可逆性的作用?

- 怎么满足可逆性?

我们先从第一个问题开始。课本给出的定义如下:

[!NOTE] 什么是可逆性? 可逆性的定义 :若 \(\{y_t\}\) 能被一个有限阶或收敛的自回归过程表示,则序列可逆。

看上去有些晦涩。我们以 MA (1) 为例来说明可逆性及其作用。考虑简单的 MA (1) 模型:

\[ x_t = \varepsilon_t - \beta_1 \varepsilon_{t-1} = (1 - \beta_1 L) \varepsilon_t \quad \Rightarrow \quad \varepsilon_t=\dfrac{x_t}{1 - \beta_1 L} \]

其中 L 是 1.4.5.3 节中我们学过的滞后算子。我们可以使用 Taylor 展开,有:

\[ \frac{1}{1 - \beta_1 L} = 1 + \beta_1 L + \beta_1^2 L^2 + \beta_1^3 L^3 + \cdots \]

从而,

\[ \begin{split} \varepsilon_t = \frac{x_t}{1 - \beta_1 L} &= x_t + \beta_1 L x_t + \beta_1^2 L^2 x_t + \beta_1^3 L^3 x_t + \cdots \\&= x_t+\beta_1 x_{t-1} + \beta_1^2 x_{t-2} + \beta_1^3 x_{t-3} + \cdots \end{split} \]

得到:

\[ x_t =-\beta_1 x_{t-1} -\beta_1^2 x_{t-2} - \beta_1^3 x_{t-3} + \cdots +\varepsilon_t \]

形式上,我们将 MA(1) 转化成 AR(∞) 的形式。该级数收敛的充要条件是 \(|\beta_1|< 1\) 。

类似地,我们可以推导得到 q 阶 MA 模型,用滞后算子得到:

\[ \varepsilon_t= \frac{x_t}{1 - (\beta_1 L + \beta_2 L^2+\cdots+\beta_q L^q)}=[1 - (\beta_1 L + \beta_2 L^2+\cdots+\beta_q L^q)]^{-1}x_t \]

其可以转换为 AR(∞) 模型。因此,我们可以说: MA (q) 可以转换为有约束的 AR (∞) 模型 。

尽管模型 MA(q)对任意 \(|\beta_1|<∞\) 都是平稳的,但模型却不一定能转换为合理的有约束 AR(∞)模型,而是需要满足一定条件,这被称为 可逆性条件。对于具有收敛 AR 表达式的 ARMA 模型,特征多项式的根应在单位圆之外。

对于 MA (2) 模型,可逆要求: \(|\beta_2| < 1\),\(\beta_2+\beta_1 < 1\),\(\beta_2 - \beta_1 < 1\) 均成立。

最后,作为一个补充拓展,请思考:为什么这被叫做“可逆性”?

[!TIP] 【回顾】AR (1) 转化为 MA (\(\infty\)) 对于平稳的 AR (1) 模型:

\[ y_t = a_0 + a_1 y_{t-1} + \varepsilon_t, \quad \varepsilon_t \sim \text{i.i.d. } N(0, \sigma^2), \]

向前递推:AR (1) 模型可表示为:

\[ \begin{split}y_t &= a_0 + a_1 y_{t-1} + \varepsilon_t \\&= a_0 + a_1(a_0 + a_1 y_{t-2} + \varepsilon_t) + \varepsilon_t \\&= \cdots \\&= a_0(1 + a_1 + a_1^2 + \cdots) + \varepsilon_t + a_1 \varepsilon_{t-1} + a_1^2 \varepsilon_{t-2} + \cdots \\ &= \dfrac{a_0}{1 - a_1} + \varepsilon_t + a_1 \varepsilon_{t-1} + a_1^2 \varepsilon_{t-2} + \cdots \\&= \dfrac{a_0}{1 - a_1} + \sum_{i=0}^\infty a_1^i \varepsilon_{t-i}\end{split} \]

这表明当前观测值 \(y_t\) 是历史扰动项 \(\varepsilon_{t-i}\) 的加权和,权重为 \(a_1^i\)。因此,AR (1) 可以转化为 MA (\(\infty\)) 。这个知识点在 1.5.2.1 AR(1)的线性特征(#1.5.2.1%20AR(1) 的线性特征) 已介绍过(但没有证明)。 因此,我们知道:AR 可以推得 MA,现在我们证明了 MA 在一定条件下也可以证得 AR。这就是被称为“可逆性”的原因。

2.3.5.3 简练原则

在探讨完可逆性之后,我们进一步对 Box - Jenkins 方法进行探讨。Box - Jenkins 方法的基本思想是 简练原则。

正如在 2.3.3.4 信息准则 节中我们提到的,增加新的参数固然会提高拟合优度(即判定系数 \(R^{2}\) 会增加),但同时也减少了自由度。Box 和 Jenkins 证明:简练模型要比参数过多模型的预测效果更好,一个简练模型能较好地拟合数据且不需要增加无关的参数。尽管我们也希望充分地得到未来的估计参数,但是我们的目的是接近真实的数据生成过程,而不是绝对准确地刻画出这个过程(过拟合)。

[!TIP] 过拟合

- 过拟合是机器学习中的一个概念,指的是模型对训练数据的过度学习。

- 当模型过拟合时,它在训练数据上表现得非常好,但在新数据上表现不佳。这是因为模型学习了训练数据中的噪音和离群值,这些信息在新数据上无法很好地泛化。

- 过拟合就像是背诵了一组问题的答案,而不是理解其背后的原理。虽然模型可能会正确回答已知问题,但在面对新问题或已知问题的变体时却会陷入困境。

在选择最恰当模型的过程中,计量经济学家会意识到:不同的模型可能有相似的特征。

- 作为一个极端的例子,AR (1) 模型 \(y_{t}=0.5 y_{t - 1}+\varepsilon_{t}\) 有等价的无限阶移动平均表达式 \(y_{t}=\varepsilon_{t}+0.5\varepsilon_{t - 1}+0.25\varepsilon_{t - 2}+0.125\varepsilon_{t - 3}+0.0625\varepsilon_{t - 4}+\cdots\)。在大样本的情况下,将 MA (\(\infty\)) 过程近似地确定为 MA (2) 或 MA (3) 过程,可以得到一个较好的拟合优度。然而,AR (1) 模型更简练,所以更优。

同时,也要注意公因式(common factor)问题。假设我们想拟合 ARMA (2,3) 模型:

\[ (1 - a_1L - a_{2}L^{2}) y_{t}=(1+\beta_1L+\beta_{2}L^{2}+\beta_{3}L^{3})\varepsilon_{t} \]

假设 \((1 - a_1L - a_{2}L^{2})\) 和 \((1+\beta_1L+\beta_{2}L^{2}+\beta_{3}L^{3})\) 分别可被因式分解为 \((1 + cL)(1 + aL)\) 和 \((1 + cL)(1 + b_{1}L + b_{2}L^{2})\)。因为 \((1 + cL)\) 为公因式,所以有等价但更为简练的形式:

\[ (1 + aL) y_{t}=(1 + b_{1}L + b_{2}L^{2})\varepsilon_{t} \]

当我们揭开了前面的谜题后,就应该明白 \((1 - 0.25 L^{2}) y_{t}=(1 + 0.5 L)\varepsilon_{t}\) 等价于 \((1 + 0.5 L)(1 - 0.5 L) y_{t}=(1 + 0.5 L)\varepsilon_{t}\)。因此,\(y_{t}=0.5 y_{t - 1}+\varepsilon_{t}\)。

实践中,多项式也许不能完全进行因式分解,然而,若因式近似,应尝试使用更为简练的形式。为了确保模型简练,每个参数 \(a_{i}\) 和 \(\beta_{i}\) 的 \(t\) 统计量都应该大于等于 2.0(这样才能够保证在 5%显著水平下的每个系数显著地异于零)。

此外,因为具有高度多重共线性的系数是不稳定的,所以,要求系数不能彼此相关,因此,通常可从模型中删去 1 个到多个系数,同时又不会影响模型的预测效果。

2.3.5.4 样本区间外预测

ARMA 模型最重要的用途是用于预测序列的未来值,较好的样本区间外预测也能够为模型的选择提供参考。

- 首先,我们先明确基本概念:站在 \(t\) 时点预测 \(r_{t + k}\),其中 \(k∈Z^+\),称时间点 \(t\) 为 预测原点,正整数 \(k\) 为 预测步长。定义 \(\hat{r}_t(k)\) 为 \(r_t\) 从预测原点 \(t\) 向前 \(k\) 步预测值。

其次,我们认为:恰当的模型具有较好的样本区间外预测。自然地,我们要问:我怎么知道这个模型预测的效果好不好?这就涉及到了 损失函数(Loss Function) 的概念。

[!Note] 损失函数

我们使用 损失函数 评估预测的优劣。

损失函数通过数学表达式刻画模型预测值 \(\hat{y}\) 与真实值 \(y\) 的偏差。

单个样本的损失 \(L(y, \hat{y})\) 反映 预测误差,多个样本则计算平均损失。

常用的损失函数:

- 均方误差(Mean Square Error,简称 MSE),定义为:

\[ MSE(\hat{r}_t(k)) = \mathbb{E}\left(r_{t + k} - \hat{r}_t(k)\right)^2 \]

- 根均方误差(Root Mean Square Error,简称 RMSE),定义为:

\[ RMSE(\hat{r}_t(k)) = \sqrt{\mathbb{E}\left(r_{t + k} - \hat{r}_t(k)\right)^2} \]

- 平均绝对误差(Mean Absolute Error,简称 MAE),定义为:

\[ MAE(\hat{r}_t(k)) = \mathbb{E}|r_{t + k} - \hat{r}_t(k)| \]

- 在本小节中,我们使用均方误差(MSE)作为预测优劣的评判标准。

- 均方误差越小,我们就可以认为模型拟合效果越好。由此,我们希望得到的模型应该是最小均方误差的,即:选择合适的模型,使得其预测 \(\hat{r}_t(k)\) 满足 \(\mathbb{E}\left([r_{t+k} - \hat{r}_t(k)]^2 |\Omega_t \right)\) 最小。 其中:\(\Omega_t\) 表示 \(t\) 时刻所得到的所有信息。

- 使得均方误差最小的预测就是给定 \(\Omega_t\) 条件下的 \(r_{t+k}\) 的期望值,即:

\[ \hat{r}_t(k) = E\left( r_{t+k} \big| \Omega_t \right) \]

现在,我们考虑几个常用模型的预测。

2.3.5.4.1 AR 模型的向前 k 步预测

- AR(p)模型的向前一步预测:

\[ r_{t+1} = a_0 + a_1 r_t + \cdots + a_p r_{t+1-p} + \varepsilon_{t+1} \qquad \Omega_t=\{r_t, r_{t-1},...\} \]

向前一期 \(r_{t+1}\) 的点预测:

\[ \hat{r}_t (1) = E(r_{t+1}|\Omega_t) =a_0 +a_1r_t+\cdots+a_pr_{t+1-p}= a_0 + \sum_{i=1}^p a_i r_{t+1-i} \]

预测误差及其方差:

\[ e_t (1) = r_{t+1} - \hat{r}_t (1) = \varepsilon_{t+1} \quad \Rightarrow \quad {Var}(e_t (1)) ={Var}(\varepsilon_{t+1})= \sigma^2 \]

如果 \(\varepsilon_t\) 服从正态分布,则 \(r_{t+1}\) 的 95%置信区间:

\[ \left[ \hat{r}_t (1) - 1.96\sigma,\ \hat{r}_t (1) + 1.96\sigma \right] \]

- AR(p)模型的向前两步预测:

\[ r_{t+2} = a_0 + a_1r_{t+1} +a_2 r_t+ \cdots + a_p r_{t+2-p}+\varepsilon_{t+2} \qquad \Omega_t=\{r_t, r_{t-1},...\} \]

向前两期 \(r_{t+2}\) 的点预测:

\[ \hat{r}_t(2) = {E}(r_{t+2}|\Omega_t) = a_0 + a_1 \hat{r}_t (1) +a_2 r_t + \cdots + a_p r_{t+2-p} \]

预测误差及其方差:(注:大多数项都被差分消去,保留的是 \(e_t(1)\) 和最后的误差项。 )

\[ \begin{split} e_t(2) & = r_{t+2} - \hat{r}_t(2) =a_1e_t(1)+\varepsilon_{t+2}= a_1 \varepsilon_{t+1}+\varepsilon_{t+2} \\ {Var}(e_t(2)) &= {Var}(a_1 \varepsilon_{t+1}+\varepsilon_{t+2}) = (1 + a_1^2) \sigma^2\end{split} \]

如果 \(\varepsilon_t\) 服从正态分布,则 \(r_{t+2}\) 的 95% 置信区间:

\[ \left[ \hat{r}_t(2) - 1.96 \sqrt{(1 + a_1^2) \sigma^2},\ \hat{r}_t(2) + 1.96 \sqrt{(1 + a_1^2) \sigma^2} \right] \]

- 请思考:对于 AR(p) 模型的向前三步预测,点预测和预测误差分别是什么。对于预测误差的推导非常重要,与后面 k 步预测、脉冲反应函数相关。

\[ \begin{split} e_t(3)=r_{t+3}-\hat{r}_t(3)&=a_1r_{t+2}+a_2r_{t+1}-a_1\hat{r}_t(2)-a_2\hat{r}_t(1)+\varepsilon_{t+3} \\&=a_1e_t(2)+a_2e_t(1)+\varepsilon_{t+3}\\&=a_1\cdot[a_1e_t(1)+\varepsilon_{t+2}]+a_2e_t(1)+\varepsilon_{t+3}\\&=(a_1^2+a_2)e_t(1)+a_1\varepsilon_{t+2}+\varepsilon_{t+3}\\&=(a_1^2+a_2)\varepsilon_{t+1}+a_1\varepsilon_{t+2}+\varepsilon_{t+3}\end{split} \]

- AR (p) 模型的向前 k 步预测:

\[ r_{t+k} = a_0 + a_1r_{t+k-1} + \cdots + a_p r_{t+k-p}+\varepsilon_{t+k} \qquad \Omega_t=\{r_t, r_{t-1},...\} \]

向前 k 期 \(r_{t+k}\) 的点预测:

- 当 \(k<p\) 时,模型包含 k 个预测项和(p-k)个已有信息。

\[ \begin{split} \hat{r}_t(k) = {E}(r_{t+k}|\Omega_t) &= a_0 + a_1 \hat{r}_t(k-1) +a_2 \hat{r}_t(k-2)+ \cdots +a_{k-1} \hat{r}_t(1) \\& + a_k r_t +a_{k+1} r_{t-1} \cdots + a_p r_{t+k-p} \end{split} \]

- 当 \(k≥p\) 时,模型只包含 p 个预测项。

\[ \hat{r}_t(k) = {E}(r_{t+k}|\Omega_t) = a_0 + a_1 \hat{r}_t(k-1) +a_2 \hat{r}_t(k-2)+ \cdots +a_{p} \hat{r}_t(k-p) \]

[!NOTE] 【思考】当 \(k\rightarrow \infty\) 时的点预测 当 \(k\rightarrow \infty\) 时,

\[ \begin{split}&\hat{r}_t(\infty)= a_0 + a_1 \hat{r}_t(\infty) + \cdots +a_{p} \hat{r}_t(\infty) \\ \\ \Rightarrow & \quad \hat{r}_t(\infty)= \dfrac{a_0}{1-(a_1+\cdots+a_p)}=\dfrac{a_0}{\sum_{i=1}^p a_i}\end{split} \]

这是什么?\(E(r_t)=a_0+\sum_{i=1}^p a_iE(r_{t-i})\quad \Rightarrow \quad E(r_t)=\dfrac{a_0}{\sum_{i=1}^p a_i}\),即:

\[ \hat{r}_t(\infty)=E(r_t) \]

这就是 “均值回转”:长期的点预测趋于无条件均值。

向前 k 期的预测误差及其方差:

\[ e_t(k) = r_{t+k} - \hat{r}_t(k) = \sum_{j=0}^{k-1} \psi_j \varepsilon_{t+k-j} \quad \Rightarrow \quad \text{Var}(e_t(k)) = \sigma^2 \sum_{j=0}^{k-1} \psi_j^2 \]

如果 \(\varepsilon_t\) 服从正态分布,则 95%置信区间:

\[ \left[ \hat{r}_t(k) - 1.96 \sqrt{\text{Var}(e_t(k))},\ \hat{r}_t(k) + 1.96 \sqrt{\text{Var}(e_t(k))} \right]. \]

其中 \(\psi_j\) 为 AR 模型的 脉冲响应函数 。

[!TIP] 什么是脉冲响应函数? 含义:脉冲是指某一时刻的随机扰动项发生一个单位的瞬时变化。脉冲反应函数就是描述这一冲击对后续观测值 \(y_{t+k}\) 的影响程度。 公式:

\[ IRF(k)=\dfrac{\partial y_{t+k}}{\partial \varepsilon_t} \quad (k=0,1,2,\cdots) \]

对于 AR(1) 模型,将 AR 模型转换为无限阶移动平均形式,对 t+k 期的预测就是

\[ y_{t+k} = \frac{a_0}{1 - a_1} + \sum_{i=0}^\infty a_1^i \varepsilon_{t+k-i} \]

那么,\(t\) 期冲击 \(\varepsilon_t\) 对 \(y_{t+k}\) 的贡献(即,脉冲反应函数)就是 \(y_{t+k}\) 对 \(\varepsilon_t\) 的偏导数。因此,我们需要先找到 \(\varepsilon_{t}\) 的项: 当 \(i = k\) 时,\(\varepsilon_{t+k-i} = \varepsilon_{t}\),因此 \(\varepsilon_t\) 对应的项为 \(a_1^k \varepsilon_t\) 。 \(y_{t+k}\) 对 \(\varepsilon_t\) 的偏导数仅保留含 \(\varepsilon_t\) 的项: